para las

ciencias sociales,

del

comportamiento

Haroldo Elorza Pérez-Tejada

Australia • Brasil • Corea • España • Estados Unidos • Japón • México • Reino Unido • Singapur

para las

ciencias sociales,

del

comportamiento

Presidente de Cengage Learning Latinoamérica:

Javier Arellano Gutiérrez Director general México y Centroamérica:

Héctor Enrique Galindo Iturribarría Director editorial Latinoamérica: José Tomás Pérez Bonilla

Director editorial: Lilia Moreno Olvera Editor:

Felipe de Jesús Castro Pérez Coordinador de preprensa: Alejandro A. Gómez Ruiz Editora de producción: Abril Vega Orozco Director de producción: Raúl D. Zendejas Espejel Supervisor de manufactura: Israel Robles Martínez Diseño de portada: Edith Ramirez Flores Composición tipográfica: Foto Grafic & Diseño

Col. Cruz Manca, Santa Fe C.P. 05349, México, D.F.

Cengage Learning™ es una marca registrada usada bajo permiso.

DERECHOS RESERVADOS. Ninguna parte de este trabajo amparado por la Ley Federal del Derecho de Autor, podrá ser reproducido, transmitido, almacenado o utilizado en cualquier forma o por cualquier medio, ya sea gráfico, electrónico o mecánico, incluyendo, pero sin limitarse a lo siguiente: fotocopiado, reproducción, escaneo, digitalización, grabación en audio, distribución en Internet, distribución en redes de información o almacenamiento y recopilación en sistemas de información a excepción de lo permitido en el Capítulo III, Artículo 27 de la Ley Federal del Derecho de Autor, sin el consentimiento por escrito de la Editorial.

Datos para catalogación bibliográfica: Elorza, Haroldo Pérez-Tejada Estadística para las ciencias sociales, del comportamiento y de la salud. 3a. ed. ISBN-13: 978-607-481-345-6

ISBN-10: 607-481-345-0 Visite nuestro sitio en:

v

• • • • • •

Prefacio... xv

Acerca del autor... xvii

Acerca de MacStat 3.0 ... xx

P

ARTE

1 E

STADÍSTICA Y CIENCIA

... 1C

APÍTULO1

A

SPECTOS FUNDAMENTALES DE LA CIENCIA... 3Propósitos... 3

Introducción... 4

Explicación y teoría... 5

Naturaleza de la investigación... 6

Justificación frente a confrontación... 9

¿De dónde surgen las teorías?... 9

Relaciones entre estadística e investigación... 9

Error de medida y error experimental... 10

Medición y estadística... 11

Escalas de medición... 12

Limitaciones de las estadísticas por nivel de medida... 13

Inferencia estadística y científica... 13

Diseño experimental... 14

Diseño cuasiexperimental... 15

Métodos cualitativos... 15

Estadística e informe científico... 16

Gráficas... 16

Resumen... 16

P

ARTE

2 M

ODELOS DETERMINÍSTICOS

... 17C

APÍTULO2

D

ESCRIPCIÓN DE DATOS... 19Propósitos... 19

Introducción... 20

Datos agrupados Gráficas y distribuciones de frecuencia... 20

Gráfica circular (o de sectores)... 20

Gráfica de barras... 21

Diagrama de tallo y hojas... 23

Histograma... 24

Polígono de frecuencias... 24

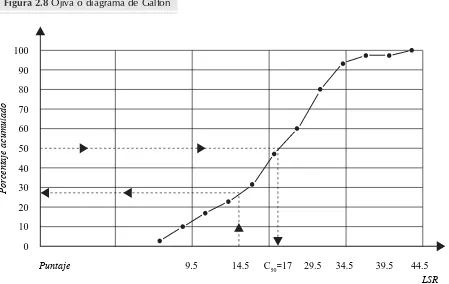

Polígono de frecuencias acumuladas u ojiva... 25

Tablas de distribución de frecuencias... 25

Construcción y representación gráfica... 25

Diagrama de Pareto... 34

vi

• • • • • •Sumatorias... 37

Medidas de tendencia central... 39

Mediana (Me)... 39

Moda (Mo)... 39

Media aritmética (x)... 40

Asimetría (As)... 43

Cuantilas... 44

En forma gráfica... 44

En forma analítica... 47

Relación de la curva de porcentajes acumulados (ojiva) y las cuantilas... 49

Rangos centílicos... 52

Empleo de centiles... 52

Diagrama de caja... 53

Medidas de dispersión o variabilidad... 55

Ejemplo de cálculo de Dm, s, s2y CV... 55

Propiedades de la distribución de frecuencias... 58

Asimetría (As)... 59

Curtosis... 60

Modalidad... 61

Datos no agrupados... 62

Medidas de dispersión o variabilidad... 63

Amplitud de variación (A)... 64

Desviación media (Dm)... 64

Desviación estándar (s, m)... 65

Varianza (s2o m2)... 67

Coeficiente de variación (CV)... 68

Ejemplos para datos no agrupados... 69

Otros tipos de promedio... 70

Media ponderada xp... 70

Media armónica (H)... 70

Media geométrica (Xg)... 71

Resumen... 72

Ejercicios... 73

C

APÍTULO3

C

ONJUNTOS,

FUNCIONES Y MATRICES... 83Propósitos... 83

Introducción... 84

Conjuntos, conceptos y notación... 84

Conjunto... 84

Elemento... 84

Reglas y formas para enunciar los conjuntos... 85

vii

• • • • • •

Relaciones entre conjuntos... 86

De pertenencia... 86

De inclusión... 86

Subconjuntos... 86

Conjuntos ajenos... 87

Conjunto universal... 87

Conjunto vacío... 88

Conjuntos iguales... 88

Conjuntos similares... 88

Diagramas de Venn-Euler y de Carroll... 88

Conjunto complemento... 91

Álgebra de conjuntos... 91

Unión (F)... 92

Intersección (E)... 93

Diferencia o resta aritmética (A<B)... 95

Diferencia simétrica entre dos conjuntos (A6B)... 96

Propiedades de los conjuntos... 97

Conteo de elementos... 99

Cardinalidad... 99

Conteo de elementos para tres conjuntos... 101

Conteo de elementos para más de tres conjuntos... 103

Producto cartesiano... 104

Relaciones y funciones... 107

Dominio y contradominio... 108

Variables dependientes e independientes... 111

Intervalos y desigualdades... 112

Clasificación de funciones... 113

Álgebra de funciones... 130

Matrices... 131

Orden de una matriz... 131

Tipos de matrices... 132

Determinantes... 134

Determinantes para matrices de 2 × 2... 135

Determinantes para matrices de 3 × 3... 135

Álgebra de matrices... 136

Operaciones matrices... 137

Sistema de ecuaciones lineales... 141

Resumen... 150

Ejercicios... 150

C

APÍTULO4

A

NÁLISIS COMBINATORIO... 161Propósitos... 161

Introducción... 162

viii

• • • • • •Principios fundamentales del conteo... 163

Diagramas de árbol... 163

Principio de la multiplicación... 166

Principio de la adición... 166

Permutaciones (Pn, r)... 169

Cuando r < n... 169

Cuando r = n... 169

Circulares... 170

Combinaciones... 171

Coeficiente multinomial o particiones... 172

Teorema del binomio... 173

Resumen... 174

Ejercicios... 175

P

ARTE

3 M

ODELOS NO DETERMINÍSTICOS

... 179C

APÍTULO5

M

UESTREO... 181Propósitos... 181

Introducción... 182

Algunos conceptos básicos... 182

Censo y muestra... 182

Población objetivo... 183

Marco de muestreo... 184

Tipos de muestreo... 184

Muestreo no probabilístico... 185

De juicio... 186

Por cuotas... 186

Bola de nieve... 187

Por conveniencia... 188

Muestreo probabilístico... 188

Fundamentos de muestreo probabilístico... 189

Conceptos básicos... 189

Muestreo aleatorio simple... 192

Muestreo aleatorio estratificado... 196

Muestreo por conglomerados... 200

Resumen... 208

Ejercicios... 208

C

APÍTULO6

C

ÁLCULO PROBABILÍSTICO... 211Propósitos... 211

Introducción... 212

Definiciones, símbolos y terminología... 213

Símbolos y terminología... 215

ix

• • • • • •

Particiones... 217

Eventos mutuamente excluyentes (me)... 218

Probabilidad condicional... 225

Eventos independientes... 227

¿Eventos mutuamente excluyentes o independientes?... 229

Probabilidad marginal... 231

Teorema de la probabilidad total... 232

Teorema de Bayes... 236

Procesos estocásticos... 245

Conceptos y definiciones... 245

Cadenas de Markov... 246

Representación gráfica... 246

Representación matricial... 248

Resumen... 259

Ejercicios... 260

C

APÍTULO7

D

ISTRIBUCIONES PROBABILÍSTICAS... 273Propósitos... 273

Introducción... 274

Variable aleatoria... 274

Desigualdad de Chebyshev... 274

Ley de los grandes números... 277

Distribución de Bernoulli... 277

Distribución binomial... 279

Características o parámetros de la distribución binomial... 284

Distribución de Poisson... 284

Características o parámetros de la distribución de Poisson... 286

Aproximación de la distribución binomial a la de Poisson... 287

Distribución hipergeométrica... 287

Distribución normal... 288

Distribución Z... 291

Aproximación de la distribución binomial a la normal... 294

Corrección de continuidad... 295

Distribución exponencial... 296

Resumen... 298

Ejercicios... 299

P

ARTE

4 I

NFERENCIA ESTADÍSTICA

... 305C

APÍTULO8

C

ONCEPTOS BÁSICOS DE LA INFERENCIA... 307Propósitos... 307

Introducción... 308

Métodos de inferencia estadística... 308

x

• • • • • •Estimación intervalar... 314

Lineamientos básicos del diseño de experimentos, investigaciones y estudios... 316

Estudio piloto... 317

Variables... 318

Transformaciones... 318

Normalización de datos... 318

Hipótesis estadísticas y científicas... 319

Hipótesis nula (H0)... 320

Hipótesis alternativa (H1)... 320

Clasificación de hipótesis... 321

Diferentes tipos de error en la investigación... 322

Sesgos... 323

Nivel de significancia, valor py potencia... 323

Contrastación de hipótesis... 324

Curva característica de operación... 324

Reglas operativas para realizar un contraste de hipótesis... 328

Relación entre tamaño de muestra y prueba de hipótesis... 329

Resumen ... 335

Ejercicios... 336

C

APÍTULO9

E

STUDIO DE UNA POBLACIÓN... 339Propósitos... 339

Introducción... 340

Error estándar de la media... 340

Intervalo de confianza y contrastación de hipótesis para una media poblacional cuando su varianza es conocida... 341

Intervalo de confianza para la media aritmética poblacional y contraste de hipótesis cuando la varianza poblacional es desconocida... 344

Intervalo de confianza y contraste de hipótesis para una diferencia de promedios con muestras relacionadas... 346

Prueba Ade Sandler... 351

Intervalo de confianza y prueba de hipótesis para una proporción... 354

Contraste de hipótesis e intervalo de confianza para una varianza... 356

Ejercicios... 359

C

APÍTULO10

E

STUDIO DE DOS POBLACIONES... 365Propósitos... 365

Introducción... 366

Intervalo de confianza y contraste de hipótesis para dos medias... 366

Intervalo de confianza y contraste de hipótesis para dos proporciones... 373

Intervalo de confianza y contraste de hipótesis para dos varianzas... 377

Contraste para más de dos varianzas... 381

xi

• • • • • •

Prueba de Hartley... 383

Prueba de Bartlett... 384

Resumen... 390

Ejercicios... 390

C

APÍTULO11

A

NÁLISIS DE VARIANZA DE UN FACTOR... 397Propósitos... 397

Introducción... 398

La lógica del análisis de varianza... 399

Diseño completamente aleatorizado... 399

Para dos tratamientos (k= 2) con igual número de sujetos... 399

Supuestos del análisis de varianza... 418

Prueba de Dunnett (d)... 419

Resumen... 420

Ejercicios... 421

C

APÍTULO12

A

NÁLISIS DE VARIANZA DE DOS FACTORES... 427Propósitos... 427

Introducción... 428

Diseño de bloques aleatorizados... 428

Diseño completamente aleatorizado... 434

Concepto de interacción... 439

Resumen... 442

Ejercicios... 443

P

ARTE

5 A

SOCIACIÓN

... 451C

APÍTULO13

A

NÁLISIS DE REGRESIÓN LINEAL... 453Propósitos... 453

Introducción... 454

El modelo de regresión... 454

Cálculo de la recta de regresión... 455

Evaluación de la ecuación de regresión... 458

Intervalos de confianza para y ... 458

Pruebas de hipótesis para la regresión... 462

Análisis de correlación... 465

Intervalo de confianza para el coeficiente de correlación... 466

Valor promedio del coeficiente de correlación... 467

Prueba de hipótesis para el coeficiente de correlación... 468

Covarianza... 470

Prueba de hipótesis entre dos rectas de regresión... 474

Comparación entre dos coeficientes de correlación... 476

Análisis de regresión múltiple... 479

Caso particular para dos variables independientes... 479 +Y X|

xii

• • • • • •Relación entre el análisis de varianza y el de regresión múltiple... 483

Evaluación de la ecuación de regresión múltiple... 484

Prueba de hipótesis para los coeficientes de regresión... 487

Coeficiente de correlación múltiple... 489

Resumen... 490

Ejercicios... 490

C

APÍTULO14

E

STADÍSTICA NO PARAMÉTRICA... 497Propósitos... 497

Introducción... 498

Pruebas de bondad de ajuste... 498

Ji-cuadrada (r2)... 499

Kolmogorov-Smirnov (K-S)... 509

Prueba de la Ude Mann-Whitney... 511

Ji-cuadrada de dos proporciones binomiales... 518

Prueba de rangos con signos en pares de Wilcoxon... 521

Prueba de la mediana... 526

Prueba de Kruskal-Wallis (H)... 529

Prueba de Friedman... 532

Prueba de Nemenyi... 535

Coeficiente de Spearman (rs)... 536

Interpretación de los resultados... 541

Prueba de significancia de rs... 541

Coeficiente TAU (

o

) de Kendall... 542Coeficiente de concordancia (t) de Kendall ... 545

Prueba de significancia de t... 548

Coeficiente de correlación (rbp) biserial de punto... 548

Prueba de significancia de rbp... 552

Prueba de Kappa... 553

Resumen... 555

Ejercicios... 555

C

APÍTULO15

C

ONCEPTOS BÁSICOS DE EVALUACIÓN Y ANÁLISIS DE DATOS CATEGÓRICOS... 563Propósitos... 563

Introducción... 564

Estudios evaluativos, un enfoque actual... 564

Definiciones y conceptos... 564

Consideraciones para los estudios evaluativos... 564

Los diferentes objetos de la evaluación... 565

Estudios evaluativos: procedimientos generales... 566

Áreas de interés del estudio evaluativo... 569

xiii

• • • • • •Interpretación de resultados... 569

La evaluación referida a una norma... 570

La evaluación referida al criterio... 570

Un modelo de investigación... 571

Propósitos... 571

Datos iniciales... 571

Tipo y tamaño de muestra... 573

Instrumento de investigación... 575

Procesamiento y análisis de datos... 577

Informe final... 577

Tablas de contingencia... 578

Prueba de homogeneidad... 578

Prueba de independencia... 581

Procedimiento post hoc... 584

Prueba exacta de Fisher... 594

Prueba de McNemar... 595

Resumen... 598

Ejercicios... 599

P

ARTE

6 I

NTRODUCCIÓN A LA MEDICIÓN

... 601C

APÍTULO16 T

EORÍA DE LA RESPUESTA AL ÍTEM... 603Propósitos... 603

Introducción... 604

Teoría clásica de los tests en la psicometría... 604

Supuestos básicos de la teoría de la puntuación verdadera... 605

Confiabilidad de un test... 605

Condiciones de paralelismo... 606

Características de los ítems en la TCT... 606

Principales limitaciones de la teoría clásica de los tests... 607

¿Qué ofrece la teoría de la respuesta al ítem?... 607

Curva característica del ítem (CCÍ)... 608

Modelo ideal de Guttman y parámetros de un ítem... 609

Índice de dificultad... 610

Discriminación de un ítem... 610

Parámetro de seudoadivinación... 610

Modelo de ojiva normal... 611

Reparametrización del modelo de ojiva normal... 612

Modelo logístico de un parámetro o modelo de Rasch... 614

Modelo logístico de dos parámetros... 615

Modelo logístico con tres parámetros... 616

Principales supuestos de la TRÍ... 617

Unidimensionalidad del test... 617

xiv

• • • • • •Estimación de parámetros del examinado y los ítems... 618

Método de estimación de máxima verosimilitud... 618

Estimación de los parámetros: ay b... 619

Función de información... 619

Usos de la función de información... 620

Función de información del test... 620

Evaluación de bondad de ajuste del modelo... 621

Interpretación del índice de bondad de ajuste... 621

Modelos politómicos de la teoría de la respuesta al ítem... 622

Modelos politómicos para categorías ordenadas... 623

Modelo de respuesta graduada... 624

Ventajas de los modelos politómicos... 626

Resumen... 627

A

PÉNDICEL

OS ESCRITOS CIENTÍFICOS... 629Introducción... 630

Qué escribir... 631

Tipo de escrito... 631

Partes del manuscrito... 632

Fuentes de información... 635

Estilo... 636

Problemas éticos de un reporte de investigación... 638

Protección del derecho a la intimidad de los pacientes... 639

Organización de un manuscrito para su envio al editor... 639

Requsitos para publicaciones del área de ciencias biomédicas... 641

Requisitos para el envío de manuscritos... 642

Envío del manuscrito a la revista... 644

Referencias... 649

G

LOSARIO... 651B

IBLIOGRAFÍA... 675A

NEXO1 T

ABLAS... 677xv

• • • • • • Esta tercera edición tiene como destinatarios principales a los lectores que estudian por primera vez a la

probabilidad y la estadística aplicadas, ya sea como parte de su formación profesional o porque tienen que realizar un estudio, investigación, experimento, etc. y editarlo como tesina, tesis, cartel o artículo, con la finalidad de presentarlo en un congreso, o someterlo a consideración de un comité para su publicación y así obtener el título profesional de licenciatura, el grado de especialidad o el de maestría.

Estructura de la tercera edición

Esta obra se ha reestructurado, actualizado y ampliado.

Se conforma de 16 capítulos, en los que han participado expertos en sus áreas respectivas; por ejem-plo, en el capítulo 1, Aspectos fundamentales de la ciencia, el autor es Serafín Mercado Domenech, doc-tor en psicología por la Universidad de Texas; profesor e investigador en la División de Estudios de Posgrado de la Facultad de Psicología, en la Universidad Nacional Autónoma de México (UNAM).

En el capítulo 3, Conjuntos, funciones y matrices, intervino el actuario Carlos Ávalos Franco, subdirector de Opinión Pública del Consejo Nacional para la Cultura y las Artes (CONACULTA), organismo oficial de México.

Asimismo, en el capítulo 5, Muestreo, la autora es la actuaria Yvón Angulo Reyes, con maestría en demografía por el Colegio de la Frontera Norte, investigadora de la Unidad de Estudios de Opinión del Instituto de Investigaciones Sociales de la UNAM.

En el tema sobre evaluación, capítulo 15, participó la maestra Helga Patricia Frola Ruiz, Centro de Investigación Educativa y Profesionalización Institucional.

Por otra parte, el capítulo 16, Teoría de la respuesta al ítem, lo desarrolló José Martínez Guerrero, doc-tor en la Universidad Complutense de Madrid, actualmente profesor e investigador en la Facultad de Psicología de la UNAM.

Los capítulos restantes son de mi autoría.

Los escritos científicoslos desarrollaron la maestra Alejandra Terán Álvarez del Rey, académica de la Facultad de Estudios Superiores (FES-Iztacala) de la UNAM y el doctor Serafín Mercado Domenech. Ejercicios de final de capíítulo

Los ejercicios que vienen al final de cada capítulo se presentan con cuatro temáticas; la primera se refiere a problemas matemáticos, mientras que las otras tres se relacionan tanto con las ciencias sociales como con las del comportamiento y de la salud. Cada uno de los problemas acerca de estos tres últimos gru-pos viene señalado con los siguientes iconos:

Ciencias sociales. Ciencias de la salud.

xvi

• • • • • •CD con software

La versión MacStat 3.0, el software estadístico que viene incluido en este libro, fue actualizado por su autor, Juan Carlos Medina Sandoval, licenciado en matemáticas aplicadas por la FES-Acatlán, de la UNAM y con maestría en administración por la Universidad de Guanajuato; actualmente es director de la firma DataConsult de México.

Revisión final

La revisión final estuvo a cargo de Ignacio Méndez Ramírez, doctor en estadística por la Universidad de Carolina del Norte, ex director del Instituto de Investigaciones en Matemáticas Aplicadas, donde actual-mente es investigador, así como profesor del diplomado “La estadística VI”, en la Universidad Autónoma Metropolitana (UAM), Unidad Xochimilco. El doctor Méndez es autor de nueve libros especializados en estadística; ha colaborado en alrededor de 200 publicaciones entre artículos, capítulos en libros, traba-jos de investigación y de divulgación científica. También ha presentado más de 500 trabatraba-jos en congre-sos, simposios y conferencias, cuenta con una amplia experiencia docente, la cual incluye un periodo como rector de la Universidad Autónoma de Chapingo y dos periodos reglamentarios como director del Instituto de Investigación en Matemáticas Aplicadas y en Sistemas, de la UNAM. Respecto de la revisión efectua-da en este libro, me permito reproducir sus comentarios:

El texto ‘Estadística, para las ciencias sociales, del comportamiento y de la salud’ cubre los concep-tos básicos de la estadística y de la probabilidad. Esto desde la estadística descriptiva, a los concepconcep-tos de inferencia con una y dos poblaciones, y su extensión a varias poblaciones con las pruebas de F, así como los conceptos de regresión simple y múltiple. Además, inicia con una excelente introducción a los aspectos matemáticos que son un auxiliar para la probabilidad y la estadística; asimismo, cubre conjun-tos, funciones, matrices, permutaciones y combinaciones. También presenta las pruebas más comunes de la estadística no paramétrica y el análisis de datos categóricos. Finalmente, incluye una breve introduc-ción tanto al tema de la evaluaintroduc-ción como a la teoría de respuesta al ítem.

El tratamiento es muy adecuado para los lectores de las áreas de ciencias del comportamiento, sociales y de la salud, como se indica en el título. No se presenta de manera rigurosa la demostración de cada técnica estadística, pero sí su motivación, conceptualización y uso. Esto se hace con varios ejemplos en cada caso. Los ejercicios también están bien seleccionados y son un valioso complemen-to para el estudiante.

Este texto constituye un valioso auxiliar para el aprendizaje de la estadística y sus aplicaciones.

A todos ellos les expreso mi agradecimiento sincero y les ofrezco una disculpa por los posibles errores, tanto sistemáticos como aleatorios, que siempre están al acecho en este tipo de trabajos; me responsabi-lizo totalmente de los que pudieran ocurrir.

También deseo agradecer a Cengage Learning y al equipo que trabajó en esta edición, en especial a José Tomás Pérez Bonilla, director editorial Iberoamérica; a Abril Vega Orozco, editora de producción, y a los editores de desarrollo que llevaron a buen término este proyecto.

xvii

• • • • • • Haroldo Elorza Pérez-TejadaObtuvo la licenciatura en física en la Facultad de Ciencias de la Universidad Nacional Autónoma de México (UNAM) y es maestro en ciencias por el Rensselaer Polytechnic Institute (RPI), de Nueva York. Ha desarrollado actividades como docente en diversas instituciones de nivel medio superior, profesional y de posgrado; entre ellas están el Russell Sage College, de Nueva York; la Universidad Tecnológica de México (UNITEC), el Instituto Tecnológico Autónomo de México (ITAM), la Universidad Anáhuac (UA), la Universidad del Valle de México (UVM), el Instituto Tecnológico y de Estudios Superiores de Monterrey (ITESM), el Instituto Nacional de Ciencias Penales (INACIPE), el Colegio de Bachilleres (de la Secretaría de Educación Pública) y el Hospital de Especialidades del Centro Médico La Raza del Instituto Mexicano del Seguro Social. También es académico de posgrado en la Universidad Latinoamericana, donde a la vez forma parte del comité tutoral de la maestría en odontología.

Del mismo modo, ha sido conferencista en la Universidad de Campeche, la Universidad Veracruzana, la Universidad de Sonora, la Universidad del Bajío (en León, Guanajuato), en el Instituto Tecnológico de Villahermosa (Tabasco) y durante la XXVIII Feria Internacional del Libro del Palacio de Minería, 2007 (antigua escuela de ingeniería de la UNAM).

En esta última institución ha sido profesor a nivel bachillerato en el Colegio de Ciencias y Humanidades (CCH), en la Facultad de Contaduría y Administración y en la Facultad de Estudios Superiores de Acatlán. Actualmente colabora con la Facultad de Psicología (donde fue coordinador del área de matemáticas y estadística en el periodo que va de 1974 a 1981), también es académico e investigador en la División de Estudios de Posgrado e Investigación de la Facultad de Odontología. Además, es asesor en estadís-tica en el Instituto de Terapia Ocupacional (ITO).

Ha sido miembro de la Asociación Mexicana de Estadística, A.C. (AME), asesor de encuestas del Instituto Mexicano de Opinión Pública (IMOP) y miembro del comité editorial de la Sociedad de Ex Alumnos de la Facultad de Psicología de la UNAM. Realizó la revisión técnica del libro Fundamen-tos de estadística en la investigación social, de J. Levin (Harla, 1979). De igual forma, colaboró en el capítulo 2, del libro Dolor orofacial y desórdenes de la articulación temporomandibular, de Ángeles Medina F. y Romero Reyes M., en la editorial Trillas. También participó en estudios que se publicaron en la Revista Odontológica Mexicana, órgano oficial de la Facultad de Odontología de la UNAM. Finalmente, formó parte del equipo que realizó un estudio en el Instituto de Terapia Ocupacional, con apoyo del Consejo Nacional de Ciencia y Tecnología (CONACYT); los resultados se publicaron en

xviii

• • • • • •Yvón Angulo Reyes

Obtuvo la licenciatura en actuaría en la Facultad de Ciencias de la UNAM y la maestría en demografía en El Colegio de la Frontera Norte. Actualmente cursa el doctorado en sociología en la Facultad de Ciencias Políticas y Sociales de la UNAM. Ha sido investigadora asociada C de tiempo completo en el Instituto de Investigaciones Sociales (IIS, perteneciente a la UNAM), asignada a la Unidad de Estudios sobre la Opinión (UDESO), donde ha laborado como coordinadora técnica en 16 proyectos de

investi-gación solicitados a dicho instituto, por diversos organismos gubernamentales de México. También es pro-fesora de estadística en los niveles de licenciatura y de posgrado en varios institutos.

Helga Patricia Frola Ruiz

Realizó estudios de licenciatura y maestría en psicología en la FES-Zaragoza de la UNAM. Es ex becaria del gobierno de Canadá para el proyecto de evaluación de grupos con necesidades especiales. También se desempeña como Directora del Centro de Investigación Educativa y Profesionalización Institucional (CIEPI) desde 1994. Autora de los libros Un niño especial en mi aulay Problemas de conducta en el aula, editados en 2005 y 2007, respectivamente, por editorial Trillas, México.

Alejandra Terán Álvarez del Rey

Licenciada en medicina y maestra en medicina nuclear por la Escuela Superior de Medicina (ESM) del Instituto Politécnico Nacional (IPN), además de ser subdirectora de enseñanza del Hospital General Rubén Leñero del Gobierno del Distrito Federal. Se desempeña también como académica de la ESM del IPN y de la FES-Iztacala de la UNAM.

Carlos Ávalos Franco

Es licenciado en actuaría por la Facultad de Ciencias de la UNAM. Ha participado en investigaciones dentro del ámbito de las ciencias sociales, en los sectores público y privado.

José Martínez Guerrero

Cursó la licenciatura y la maestría en la Facultad de Psicología de la UNAM. Es doctor por la Universidad Complutense de Madrid, donde recibió el Premio Extraordinario de Doctorado de esta universidad españo-la. Actualmente funge como profesor en el Posgrado de la Facultad de Psicología, al igual que como tutor en el Programa de Medicina Conductual. Es, finalmente, investigador nacional nivel I en el Sistema Nacional de Investigadores del CONACYT.

Juan Carlos Medina Sandoval

xix

• • • • • • Serafín Mercado DomenechLicenciado en psicología por la UNAM, doctor en psicología en la Universidad de Texas (Austin, E.U.), profe-sor e investigador en la División de Estudios de Posgrado además fue fundador de la maestría en psicología ambiental en la Facultad de Psicología de la UNAM.

Adip Sabag Sabag

xx

• • • • • •Aprender estadística no es sencillo, como estudiante de licenciatura experimenté lo complicado que puede ser preparar tareas y tener que dedicar más tiempo en hacer las operaciones (sumas, multiplicaciones, potencias, etc.) que el que pude dedicar a interpretar los resultados y comprender las aplicaciones. Esta situación ocasiona que muchas personas aprendan más a hacer sumatorias que a interpretar y conocer en qué casos usar cada modelo estadístico y los beneficios que se generan al aplicarlos a las actividades cotidianas de muchas profesiones. Como resultado de lo anterior, muy pocas personas al salir de la uni-versidad recuerdan qué modelos existen y mucho menos para qué se usan.

MacStat será un gran apoyo para todos los estudiantes de licenciatura que estén aprendiendo estadística, aunque puede utilizarse en cualquier nivel, como lo comprobé al estudiar la maestría en administración, donde lo utilizamos en varias clases y proyectos para aplicar modelos estadísticos. El software también es de gran ayuda en investigaciones profesionales, situación que he encontrado en Internet, en diversas menciones del uso de MacStat para procesar información de investigaciones en varios estudios. También he visto con agrado que algunos profesores lo recomiendan a sus alumnos en los planes de estudio para que lo utili-cen en proyectos de investigación y tesis.

xxi

• • • • • • MacStat fue creado con la idea de que el estudiante de estadística cuente con una herramienta querealice las operaciones, ahorre tiempo y pueda comprender el uso del modelo y su aplicación.

La primera versión se elaboró para un concurso en la Universidad Nacional Autónoma de México (UNAM) que invitaba a los estudiantes a crear software que sirviera de apoyo para cualquier materia. La estadística es común en muchas áreas, además de que requiere realizar muchas operaciones, por lo que desarrollar un programa para esta disciplina era una opción muy alentadora. Así nació la versión 1 de MacStat; ésta fue programada para correr en sistema operativo MS-DOS que era de uso muy común en esa época. El nombre de MacStat se deriva de la licenciatura que estudiaba, matemáticas aplicadas y computación, conocida como MAC, a este nombre se agregó “Stat”, palabra comúnmente utilizada como sufijo en software de estadística. La versión del concurso contenía módulos de análisis de varianza, regre-sión simple, estadística descriptiva y operaciones de matrices. El resultado fue el primer lugar en el con-curso por su calidad y aplicación práctica de apoyo.

xxii

• • • • • •MacStat 3 fue desarrollado para acompañar a esta edición agregando nuevos modelos que eran muy solicitados como las pruebas “t”, “ji-cuadrada” y de regresión múltiple. Estos modelos pueden resultar en una gran cantidad de operaciones cuando se realizan “a mano” o “a lápiz”, pero con MacStat sólo es necesario capturar los datos de entrada y automáticamente se obtienen los resultados.

Además de estos tres modelos nuevos, se mejoraron notablemente varios aspectos tanto técnicos como de uso. Las operaciones se realizan mucho más rápido en varios modelos, se pueden copiar y pegar datos en las matrices u hojas de datos para poder aprovechar los disponibles en otros programas o en otros módulos.

Las matrices se pueden guardar en archivos para facilitar el trabajo con matrices grandes y no tener que recapturarlas cada vez que se quieran usar.

xxiv

• • • • • •La misión de MacStat es apoyar a los estudiantes durante el aprendizaje de la estadística y la apli-cación de los modelos, al liberarlos de tener que realizar las operaciones de forma manual para que puedan dedicar más tiempo productivo a comprender y aplicar.

Cuando se aprende a usar un modelo estadístico MacStat puede utilizarse para resolver problemas de muchas áreas, ya que quien aprende a usar un modelo encuentra aplicaciones prácticas en su área profesional, además de que puede estar seguro que MacStat presentará resultados con la calidad y poder de muchos paquetes comerciales, con la ventaja de ser mucho más sencillo de utilizar.

Para ser aceptada como conocimiento científico,

una verdad debe ser una deducción de otras verdades.

3

• • • • • •

Aspectos fundamentales

de la ciencia

Dr. Serafín Mercado Domenech

Facultad de Psicología, UNAM

Propósitos

El objetivo central del presente capítulo es que el lector sea capaz de ubicar a la estadística dentro del contexto de la ciencia y la investigación.

De igual forma, al término del mismo el lector podrá:

• Reconocer que la ciencia ha facilitado el desarrollo de las teorías que exponen la realidad. • Comprender la conceptualización del empirismo y del positivismo en el proceso de acumulación

del conocimiento.

• Explicar la forma en la que las teorías constituyen simplemente la organización lógica de las leyes empíricas.

• Enunciar la forma que tiene el empirismo de entender la ciencia.

• Reconocer que toda teoría, todo modelo y toda ley científica son una conjetura acerca de cómo es la realidad.

• Relacionar la opinión de Popper de que toda ley, principio, teoría o modelo es una conjetura o suposición.

• Diferenciar el punto de vista de los positivistas y los justificacionistas con relación a la ciencia. • Considerar el punto de vista de Popper acerca de que: “Lo que caracteriza al hombre de

4

• • • • • •INTRODUCCIÓN

La ciencia es una de las empresas más humanas y productivas que haya desarrollado el hombre. Si lo que caracteriza al ser humano es su excepcional inteligencia, la cual le ha dotado de lenguaje y le ha permitido servirse de él para crear una singular organización social, de insólita eficacia, para dominar la naturaleza, entonces la ciencia es el logro humano más perfecto y contundente, el cual señala la cúspi-de cúspi-de los frutos cúspi-de su intelecto, único en el Sistema Solar y tal vez en el universo mismo.

La ciencia basada en un proceso analítico y crítico produce el conocimiento que ha permitido una mejor comprensión de la realidad circundante. Asimismo, ha facultado al hombre para penetrar en los secretos más profundos del mundo, incluido el ser del hombre mismo. La ciencia ha facilitado el desa-rrollo de teorías que exponen la realidad, con base en un examen de la relación entre los intentos de explicación teórica, evidencia empírica y congruencia lógica, tanto interna a la explicación como en lo relativo a otras teorías con las que tienen vínculos conceptuales. Esto ha implicado que el científico pruebe sus teorías confrontándolas con la evidencia existente que, con el objeto de evaluar la teoría de que se trata, se acumula con procedimientos rigurosos. Asimismo, el científico está a la caza de incon-sistencias internas en la lógica de las explicaciones, así como de las contradicciones entre las diversas teorías vinculadas.

Aquí se hace relevante la discusión acerca de la naturaleza de las teorías y su desarrollo en Popper (1959, 1963, 1970, 1974 a, 1974 b)y Kuhn (1963, 1970 a, 1970 b, 1971, 1974), y las posteriores elabo-radas por Kneller (1978); Lakatos (1964, 1968 a, 1968 b, 1970, 1971, 1974, 1975); Feyerabend (1962, 1965 a, 1965 b, 1970 a, 1970 b, 1970 c), Maxwell (1974) y Weimer (1979).

La conceptualización del empirismo y del positivismo acerca de la naturaleza del proceso de acumu-lación de conocimiento se ha sustentado siempre en el proceso de inducción. Este principio señala, tal como lo plantea Hume, que si observa una cierta regularidad en los procesos naturales (incluida la naturaleza humana), entonces es posible generalizar a partir del establecimiento de una ley. De acuer-do con esta visión, el problema de la ciencia es observar cuidaacuer-dosamente la naturaleza, evitanacuer-do caer en errores debidos a la posible confusión de causas. El mejor modo de evitar el error es realizar una cuidadosa observación y medición del fenómeno y utilizar el método experimental para no confundir la verdadera causa de los fenómenos con otras que en apariencia los producen. De acuerdo con ellos, los hechos observados y establecidos pruebanuna cierta concepción de la realidad. Al ser entonces el pro-ceso científico un propro-ceso lineal y acumulativo, las teorías constituirían simplemente la organización lógica de las leyes empíricas y la explicación de varias de ellas por principios más generales, surgidos de la inducción. Esta es la forma que tiene el empirismo de entender la ciencia y, con ciertas modifica-ciones, el positivismo.

Hume ya había planteado la naturaleza de las limitaciones lógicas del conocimiento inductivo: inde-pendientemente de cuántas observaciones se hayan hecho de una regularidad, esto no da ninguna “garantía lógica” de que volverá a ocurrir del mismo modo en la siguiente ocasión. La solución plantea-da por Popper (1972) a este dilema se hizo en términos de postular que nunca se puede partir de ningu-na certidumbre acerca de ningu-nada de lo que se cree. De acuerdo con él, toda teoría, todo modelo o toda ley científica, es una conjetura de cómo es la realidad; no importa que su origen sea la inducción, un conocimiento tácito, tal vez de carácter personal, o una especulación; la teoría es una conjetura, una suposición, una hipótesis acerca de la realidad.

la pretensión de que una teoría explicativa universal es verdadera”.† Sin embargo, afirma que:

“suponiendo que los enunciados contrastadores sean verdaderos, con base en ellos a veces podemos jus-tificar la pretensión de que una teoría explicativa universal es falsa”.††Esto desplaza el énfasis de la

investigación al sentido contrario de como lo plantea el punto de vista tradicional científico: no es posible probar que las teorías sean verdaderas, sólo es factible eliminar las falsas. Por ello, Popper dice: “el método de la ciencia es el método de las conjeturas audaces e ingeniosas seguidas por intentos rigurosos de refutarlas”.†††

Esto hace de la ciencia una aventura fascinante, donde las teorías se tienen que construir; hay que inventarlas sobre la base de lo que ya se comprende del fenómeno en cuestión. No obstante, lo que hace a la ciencia más emocionante aún, es la posibilidad de someter las teorías a rigurosas pruebas de evi-dencia. Por un lado, esto otorga un grado mucho mayor de libertad, pero también un enorme sentido de responsabilidad.

De acuerdo con la opinión de Popper, toda ley, todo principio, toda teoría o todo modelo es una con-jetura, una suposición. Las teorías no surgen, como supondrían los positivistas, mediante el proceso de inducción a partir de los datos, que, en todo caso, tan sólo proporcionan una inspiracióninicial para la concepción de una teoría y no son una base empírica para el proceso lógico de la generalización por induc-ción. Los datos, cuando se generan a posteriori, sirven también para poner a prueba la elaboración de una ley o teoría, y si ésta resulta rechazada, es precisamente la naturaleza de las fallas la que podría servir de inspiración para el posterior planteamiento.

Las teorías se valoran por su poder explicativo y heurístico. Por tanto, son mejores las teorías que explican más hechos conocidos, las que tienen menos hechos que las contradicen y, sobre todo, las que per-miten internarse en lo desconocido haciendo pronósticos no triviales y novedosos, sobre cuya base se les somete a pruebas rigurosas. El carácter riguroso de la contrastación hace que las teorías cuantitativas sean mejores, permiten mayor precisión en la elaboración del pronóstico y, por tanto, en la prueba de ellas, ya que permite señalar con toda exactitud el grado de error de pronóstico y decidir si éste sólo se debe a un error de medición, o si se debe a una falla de la teoría.

Explicación y teoría

El papel de la teoría es explicar, proporcionar una comprensión de fenómenos, leyes, principios y cualquier otro tipo de hecho por medio de postulados generales, mecanismos internos, entes hipotéti-cos, procesos subyacentes o cualquier otro artificio intelectual; los que se combinan para proporcionar una estructura que dé cuenta racional de aquello que se pretende explicar. Es decir, las teorías tratan de dar sentido a aquello que explican, ubicándolo en la naturaleza y haciendo explícitas sus propiedades y relaciones con otros entes.

El propósito de la explicación es profundizar en la comprensión de los fenómenos. Por ejemplo, en el área de la química, Robert Boyle había desarrollado la distinción taxonómica entre elementos y com-puestos. A partir de esa base, Proust elaboró la ley empírica de las proporciones constantes, la cual sostiene que los elementos tienen que combinarse en una determinada proporción de peso, para producir

5

• • • • • •

† K. R. Popper, Conocimiento objetivo, Tecnos, Madrid, 1974, p. 20.

una reacción que genere un compuesto específico, sin que ninguno de los elementos que participaron en la reacción sobre, de modo que se requiere que estos elementos guarden una relación que se pueda expresar por medio de números enteros. Cuando esta proporción no se cumplía, la reacción no era com-pleta y sobraban los elementos que tenían una proporción mayor a la estipulada. Esta ley empírica era suficiente para manejar coherentemente los fenómenos de la química que influían en las reacciones entre sustancias. Sin embargo, Dalton, un inglés, modesto profesor de primaria, introdujo una de las especu-laciones más fructíferas en la historia de la humanidad: explicó esas regularidades numéricas suponien-do que la materia es discontinua y, retomansuponien-do la idea de Leucipo y Demócrito, postuló la existencia de átomos para explicar esos hechos. De acuerdo con Dalton, los átomos de cada elemento se unen en com-binaciones determinadas para formar moléculas de compuestos, las cuales son apiñamientos de átomos en estructuras determinadas. Es entonces el número de átomos de cada clase, que existe en cada molécula de un compuesto específico, lo que define la proporción de los elementos que deben entrar en la reacción para que no sobren átomos de un tipo u otro.

No ha existido una propuesta más fértil que ésta (Mercado, 1978). Al poco tiempo, no sólo daba cuenta de los fenómenos conocidos de la química, sino que asimiló la ley de Boyle-Mariott de los gases a la explicación atómica, mediante la teoría cinética de los gases, que se basó en una aplicación de la mecánica newtoniana al movimiento de los átomos y las moléculas.

Como puede observar ahora, las teorías son instrumentos intelectuales muy poderosos que permiten dar sentido a la apabullante complejidad de la experiencia fenoménica, así como lidiar con la realidad por medio de la creación de un esquema conceptual de ésta, el que supone que es así en verdad. En este sentido, la ciencia es el instrumento intelectual más importante logrado por la humanidad, después de la invención de la escritura. La ciencia permite al hombre entender y anticipar el mundo que lo rodea, gracias al desarrollo de teorías que se asemejan cada vez más a la realidad, ya que, como lo señala Popper, las teorías van siendo, por selección natural, cada vez mejores mapas conceptuales de la reali-dad y cada vez más exactos y precisos. Las teorías se transforman en las mejores guías para la praxis humana, permitiendo el desarrollo de las poderosas tecnologías que caracterizan a la época moderna y haciendo factible el enorme éxito de la especie, por el que la humanidad ha logrado la población con la que actualmente cuenta.

Naturaleza de la investigación

La investigación se considera no sólo la parte creativa de la ciencia con la que se busca expandir el conocimiento y comprensión de la realidad, sino también la base que permitirá construir un mapa de ésta capaz de guiar al hombre en su búsqueda. Los mapas que proporciona la ciencia no son únicamente esquemas descriptivos sino conceptuales-causales del mundo circundante; es decir, son guías en relación con las clases de objetos y eventos y sus conexiones causales recíprocas. Así, en función de esta situación el hombre avanza en su dominio cognoscitivo de la realidad.

La naturaleza de la ciencia y, por ende, de la investigación, han sido explicadas a través de la rama de la filosofía denominada Filosofía de la ciencia.† Esta disciplina es un esfuerzo del razonamiento

6

• • • • • •† Se ha llegado al estudio de la naturaleza del conocimiento por una variedad de ramas de la filosofía y de las ciencias

humano por comprender cuál es el fundamento de esa actividad tan exitosa llamada ciencia. La filosofía, entendida como la reflexión sobre la naturaleza última de la realidad y de la existencia humana, lleva a un razonamiento acerca de la relación cognoscitiva existente entre el hombre y la realidad, que es la rama denominada epistemología. Dentro de esa reflexión se encuentra ubicado un análisis más específico del proceso de adquisición de conocimiento por medio de la ciencia.

La ciencia, como tal, surge en forma sistemática y organizada entre los griegos. La ciencia se desa-rrolló en el año 600 a.C. en las mentes inquietas e inquisitivas de investigadores de la naturaleza y de filósofos que buscaban la esencia de la realidad, incluida la naturaleza del conocimiento; desde la filosofía de la ciencia de Aristóteles, Platón, Demócrito, etc., hasta las contribuciones empíricas y teóri-cas concretas de Anaxágoras, Aristarco, Arquímedes, entre otros.

Sin embargo, no fue sino hasta que se inicia el Renacimiento cuando surge de nuevo un concepto sis-temático del proceder científico para el avance del conocimiento, es decir, una búsqueda activa de la ver-dad a través de la experiencia y la puesta a prueba empírica de las hipótesis, siendo un hecho que casi todo lo que distingue al mundo moderno de los siglos anteriores es atribuible a la ciencia. Ésta, como práctica, surge al lado y bajo el cobijo de la filosofía empirista. Cuatro astrónomos preeminentes en la creación de la ciencia: Copérnico, Kepler, Galileo y Newton, físicos además los dos últimos, impulsaron el surgimiento de ésta, al ayudar a abrir el camino a la investigación crítica como medio para avanzar en el conocimiento, lo que obtuvo sus logros más espectaculares en el siglo XVII(Russell, 1967).

Junto a quienes practicaban la ciencia como método empírico para abordar el conocimiento, surgían los filósofos empiristas, que fundamentaban el nuevo método de obtener conocimiento. Bacon, Hobbes, Locke, Berkeley y Hume instituyen el empirismo como el único camino al conocimiento, al establecer la experiencia empírica como la única posibilidad para conocer la verdad y la inducción como el méto-do lógico que hacía posible esto al usar la inferencia como medio para el logro de conocimientos ge-nerales a partir de experiencias particulares. Ellos establecieron el conocimiento científico como un camino seguro a la verdad. Intentaban desarrollar un sistema de inferencia racional que hiciera posible la generalización a partir de experiencias particulares y concretas. Suponían también un carácter acumu-lativo de la ciencia; para ellos, los hechos son contactos objetivos con el mundo que, una vez estable-cidos, quedan de manera perenne en el acervo de conocimiento verdadero, siendo la ciencia un proceso de acumulación de hechos. En pocas palabras, con ellos, la concepción de la ciencia se desarrolla como la búsqueda en la experiencia empírica de un camino para una seguridad absoluta que justifique los conocimientos así desarrollados como productos permanentes de un método fehaciente.

Comte dio el siguiente paso en el desarrollo de una concepción de la ciencia. El desarrollo del

po-sitivismo clásicofue un avance en la concepción de la ciencia empírica y de un sistema metodológico

para su ejercicio concreto.†El positivismo considera a la experiencia como fuente de conocimiento, y los

hechos generales o leyes son la única fuente de certidumbre. Encontramos a pensadores como Mach, Avenarius, Poincaré y Pearson, entre otros, como estructuradores de una filosofía que establecía a la ciencia sobre una base empírica que se proponía como guía pragmática para enfrentar la vida. El Universo, incluyendo al hombre, estaría constituido por fenómenos que se conectan causalmente entre sí, conexiones que se podrían descubrir por medio de la inducción, controlada, en la medida de lo posi-ble, por el método experimental. Las leyes y las teorías serían símbolos convencionales que reflejarían el orden en las relaciones dentro de la naturaleza.

7

• • • • • •

Tanto el positivismo clásico como el empirismo mantienen una posición radical acerca del conocimien-to. El conocimiento putativo no pude considerarse como verdadero a menos que se le pruebe, y la prueba consiste en ponerlo bajo la hegemonía de la autoridad epistemológica pertinente, en este caso, la expe-riencia empírica (Weimer, 1979).

En la actualidad, el trabajo de filósofos con enfoques diferentes, aunque con un núcleo central de acuerdo fundamental, culmina el desarrollo de una filosofía de la ciencia empírica. Todos ellos usan la lógica y la lingüística como instrumentos para el desarrollo de una relación entre teoría y realidad, aunque el fundamento de la verdad empírica sigue siendo el criterio epistemológico último. Wittgenstein, Ayer, Carnap, Tarsky y Feigel, desde el positivismo lógico; Russell y Whitehead, desde una combinación de realismo crítico y filosofía analítica y Moore, Wittgenstein y Wisdom, desde la filosofía analítica, abordan la búsqueda de la verdad mediante variantes de un mismo esquema funda-mental. Si la inferencia no puede demostrar su validez absoluta como método lógico para establecer conocimiento verdadero, es decir, no se le puede probar, el concepto de inducción se sustituye por uno de inducción probabilística. Se fusionan los conceptos de inducción y probabilidad, y es necesario pro-bar el conocimiento en términos de probabilidades.

Este punto de vista de la ciencia prevaleció sin desafío hasta el siglo pasado, pero en la actualidad ha surgido con gran vigor la perspectiva de la ciencia, ya mencionada, llamada no justificacionista, que analiza el proceso de conocimiento científico sin recurrir al de la justificación empírica como base para el establecimiento de éste. Como ya se vio, autores como Popper, Kuhn, Lakatos, Feyerabend y Weimer han jugado un papel muy importante para dar esa visión alternativa de la ciencia.

La visión de la investigación científica desarrollada por las filosofías empírica y positivista fue relati-vamente clara. Existen dos tipos de entes: los hechos y las teorías. Los primeros provienen del ingreso sensorial, mientras que las segundas son conjuntos de proposiciones que surgen de los hechos a partir de la inducción. El problema es sencillo: hay que probar las teorías asegurando que sus conceptos tengan una relación unívoca con los hechos establecidos por inducción.

Weimer (1979) llama justificacionismo†al denominador común de todas estas aproximaciones porque

encuentra a la “metateoría” como la concepción de que hay una fuente de autoridad que produce una jus-tificación incontrovertible para un método. En esto, afirma que tanto el racionalismo como el empiris-mo-positivismo parten de una misma posición fundamental; de lo que Dewey llamó búsqueda de la

certeza. El racionalismo lo hace apelando a la autoridad del intelecto, mientras que el

empirismo-posi-tivismo a la del ingreso sensorial.

Popper (1974) señala que es precisamente esa búsqueda de una base firme e incontrovertible la fuente de los problemas. Hace un análisis sobre la reflexión de Hume (1927, 1960) acerca de la inducción y coincide con él en que no es posible que partiendo de la observación de una serie de casos reiterados de una relación determinada se llegue a una conclusión válida acerca de casos aún no observados; es decir, no se justifica desde el punto de vista lógico la inferencia. La solución que ofrece para no caer en un solipsismo estéril es que, si bien no es posible de modo alguno comprobar teorías, sí es factible refutar-las. Su solución para el funcionamiento de la ciencia puede resumirse en la idea de que la ciencia opera sobre la base de conjeturas que se someten a una prueba rigurosa ante la evidencia empírica y ante el análisis de la consistencia lógica. En esta perspectiva no justificacionista, la teoría no surge

directa-8

• • • • • •† El no justificacionismose inicia propiamente a partir del trabajo seminal de Popper y Kuhn, quienes hacen una crítica

mente de los datos a partir de un proceso de inducción, ya que cualquier proposición teórica, desde una simple ley empírica hasta un modelo teórico o una teoría, proviene de una conjetura. El origen puede ser, como se señaló anteriormente, cualquier posible fuente: la observación de una o varias regulari-dades, una especulación teórica, una analogía o algún otro proceso. Lo importante es, como ya se ha dicho, que las conjeturas científicas se ponen a prueba por medio de la crítica lógica y empírica (a dife-rencia de las conjeturas puramente especulativas en otros ámbitos). No obstante, si los hechos apoyan la teoría, no cabe pensar que la justifican, sólo que hasta ahora no la han refutado.

Justificación frente a confrontación

De acuerdo con Lakatos (1970), un programa de investigación se juzga a partir de su comportamiento comparado con programas rivales. La conciencia de nuevas variables extrañas generalmente se da en torno a la competencia entre teorías rivales; el investigador no se percata de qué variables debe contro-lar hasta que otra explicación sugiere los aspectos que debe considerar con más cuidado para decidir cuál explicación es la que mejor da cuenta de los hechos. Lakatos (1968b) asevera que no es tan impor-tante el choque entre teoría y datos como la competencia entre las teorías rivales. La actitud rigurosa no implica la supresión instantánea de una teoría, sino la exploración seria y crítica de sus posibilidades frente a otras opciones de explicación. Tal como señala Weimer, “en la mayoría de los casos en la prác-tica científica actual, el medio más efectivo de críprác-tica disponible para un investigador es permanecer comprometido con una posición para poder articularla plenamente y explorar sus consecuencias” (Weimer, 1979, p. 49).

¿De dónde surgen las teorías?

Como se ha visto, las teorías científicas son intentos de explicación de la realidad, confrontadas con los hechos de manera rigurosa, que compiten entre sí para tratar de encontrar la mejor manera de dar cuen-ta de los hechos. Son sistemas de creencias acerca del mundo, más explícitos, claros y precisos que otros conjuntos de creencias (la religión, el sentido común, las seudociencias, etc.), y que son someti-dos a una rigurosa prueba sistemática. Las teorías pueden tener una génesis muy diversa. Por una parte, se encuentra el conocimiento tácito de muchos aspectos de la realidad, donde el sentido común y el conocimiento personal son una fuente muy importante de hipótesis científicas (Polanyi, 1958). En la vida cotidiana observa casualmente muchos hechos que después lleva al laboratorio y examina con más cuidado. Con frecuencia, esas mismas observaciones inspiran los primeros intentos de explicación, que al desarrollarse pueden ser la base de una teoría. Otra fuente común son los accidentes en el proceso de investigación, que llevan a encontrar lo que no busca y se le ha denominado serendipia. En otras oca-siones, las teorías surgen de una observación cuidadosa de los hechos, tal vez experimentales, y el desarrollo de una inferenciaa partir de ellos, entendiendo que lo observado da claves para la construc-ción de la explicaconstruc-ción. Otro origen frecuente de teorías es la observaconstruc-ción de una discrepancia entre algunos hechos y una teoría. Esto puede llevar a una reflexión que dé lugar al desarrollo de una teoría alterna y resuelva el conflicto.

RELACIONES ENTRE ESTADÍSTICA E INVESTIGACIÓN

El tema de este capítulo es examinar el papel que tiene la estadística en la investigación científica. La estadística es una rama de las matemáticas que se dedica a entender los fenómenos que tienen un

cier-9

10

• • • • • •to grado de azar. En la ciencia se enfrenta el problema de que los fenómenos son multicausales y existe una diversidad de aspectos de los que sólo se tiene un grado de control relativo. Frente a esta problemáti-ca, resulta útil emplear un método que permita lidiar con datos con una cierta dosis de incertidumbre. En realidad la estadística es un instrumento muy valioso para organizar la información científica y para tomar decisiones acerca de ella; sería imposible concebir la investigación científica moderna sin dicha estadística.

La investigación, con muy raras excepciones, se refiere a grupos de datos e incluso a grupos de objetos, plantas, animales o personas. Un investigador en astronomía puede tomar varios registros de la distancia a la que se encuentra la Luna o algún objeto lejano con una técnica específica (por ejemplo, usando un radar) para controlar el error de medida, y luego usar la estadística para decidir si su nueva medición es igual o diferente a la que tuvo usando un método más primitivo. Un psicólogo, puede medir la ejecución de una tarea por tres grupos de sujetos en un experimento que difieran en la cantidad de alcohol que han ingerido, para ver el efecto sobre una tarea consistente en colocar palitos en agujeros hechos en una tabla. En este caso, es posible usar la estadística para establecer si hay diferencias entre estos grupos de sujetos.

Error de medida y error experimental

Existen dos conceptos de gran importancia en los que la estadística tiene un papel preponderante: los errores de medida y los experimentales. Ambos son importantes fuentes de problemas para el investi-gador y poderosas razones para usar la estadística en la investigación.

El error de medida es el que se comete al medir cualquier cosa a pesar del cuidado que se tenga. Por una variedad de razones es posible cometer dos tipos de error: el sistemático, que implica una falla regu-lar en una dirección (por ejemplo, un metro un poco más grande de lo debido) o el aleatorio, que se refiere a inexactitudes de un instrumento al medir con él. El primero produce distorsiones de nuestros datos, que a la vez implican un error en nuestras conclusiones.

Los errores sistemáticos pueden radicar en fallas de calibración de los instrumentos. Los instrumen-tos de medición deben ser comparados con un estándar, el cual determina que el instrumento efectiva-mente arroja los valores adecuados a la escala que está usándose. Por ejemplo, el metro tiene como estándar de calibración una varilla de vanadio-iridio, colocada sobre un soporte especial en una cámara con temperatura y ambiente controlados que se encuentra en la Oficina de Pesos y Medidas en París, Francia. Los estándares de calibración de los diversos países se obtienen marcando otra varilla similar en sitios análogos a los de la varilla estándar y conservándolos en condiciones similares. Los instrumen-tos psicométricos (tests) se estandarizan (una forma de calibración) aplicándolos a una gran muestra de la población donde van a usarse (por ejemplo, la ciudad de La Plata o México), y luego se establecen las calificaciones estándar. Es decir, si se usa una prueba de inteligencia en México y se emplean están-dares ingleses o argentinos, se estaría produciendo un error sistemático de medida.

Los errores sistemáticos también pueden ser causados por la influencia de alguna variable ajena que afecta el proceso de medición, por ejemplo, la presencia de un campo electromagnético cerca de un instrumento de medición con una aguja de bobina, como lo pudiera ser un sonómetro, o un efecto de una variable no adecuadamente controlada como el sexo o la clase social del encuestador en una prue-ba de personalidad.

11

• • • • • •

influencia accidental, de carácter temporal, de otras variables, como el estado de ánimo de un sujeto al someterse a una prueba, las variaciones accidentales de la corriente eléctrica al medir con equipo electróni-co que use la energía de la red eléctrica, o el efecto de la temperatura en el funcionamiento de un equipo. La estadística permite lidiar con ambos tipos de error. El error sistemático se establece viendo si un grupo de medidas difiere de un estándar bien establecido; por ejemplo, verificar si los metros que se usan en Polonia difieren del metro en la Oficina de Pesos y Medidas en París. Para esto se usan ciertas formas de estadística inferencial.

El error aleatorio se anula a través de la estadística. Es posible comparar medidas con error y esti-mar el valor casi exacto de cierta medida gracias a la estadística.

MEDICIÓN Y ESTADÍSTICA

La estadística se aplica sobre medidas obtenidas de los diversos objetos de estudio en diferentes condi-ciones. Por ejemplo, si desea verificar si un curso de capacitación para soluciones de problemas, mejo-ra la inteligencia de quienes lo cursaron, puede tener un grupo al cual le mide la inteligencia antes y después de llevar el citado curso; es decir, aplica la estadística sobre medidas tomadas de los casos, antes y después de la intervención.

Medir, según Torgerson (1958), es asignar números a una propiedad de acuerdo con una regla.†Es decir,

medir es una forma particular de observación en la cual se asignan números a las propiedades observadas. Es de notar que esta asignación no es del todo arbitraria, ya que usa una regla de asignación de números a los valores de la propiedad. Algo que es necesario comprender, es que debe abstraer la dimensión, lo cual es más difícil si se trata de aspectos no observables directamente, como el nivel del metabolismo basal, el peso de los átomos o la inteligencia.

En la vida cotidiana, sin duda, aparecen numerosas formas de medir, como usar una báscula para pesar. El peso se refiere a estándares, como el gramo, que es el peso de un centímetro cúbico de agua a nivel del mar. La regla para pesar consiste en comparar el peso del objeto de interés con el de un están-dar. El número (valor) es asignado de acuerdo con la regla de que el peso del objeto sea igual o un múlti-plo del peso del estándar.

Las balanzas son, tal vez, las que permiten ver esto de modo más directo; porque una varilla sus-pendida horizontalmente por el centro de un postecillo indica que se encuentra equilibrada y, si cuelga en los extremos unos platillos de igual peso, el equilibrio no se altera. En esta balanza pone el objeto que quiere pesar (harina) y se asegura de que tiene un kilogramo colocando en uno de los platillos el estándar de un kilogramo y en el otro la harina. Si el equilibrio se mantiene, entonces tiene el peso deseado. Si no fuese así, tendría que agregar o quitar harina hasta lograr el equilibrio, o puede cambiar o combinar estándares.

Las básculas modernas tienen un plato de un lado, suspendido sobre el brazo de la báscula, y del otro lado, un brazo sobre el cual corre un peso estándar; el efecto del peso varía al correr el estándar sobre el brazo de la palanca.

Otro uso de la estadística en psicología y ciencias afines es el desarrollo de modelos psicométricos. Estos modelos se basan en una teoría que plantea que la respuesta a un problema, pregunta o algo simi-lar, depende de diversas variables. Si selecciona una de esas variables para medirla, también puede

† Medición numérica.