1.- La evaluación de programas:

consideraciones generales.

1.1 DIMENSIONES DE LA EVALUACIÓN.- ... 11

1.2 EL PROGRAMA Y SU EVALUACIÓN.-... 17

1.3 EL PROCESO DE EVALUACIÓN DE PROGRAMAS.-... 22

1.4 LA PLANIFICACIÓN EN LA EVALUACIÓN DE PROGRAMAS.- ... 26

1.5 LA INSTRUMENTALIZACIÓN EN LA EVALUACIÓN DE PROGRAMAS... 29

1.6 PROBLEMÁTICAS-DIFICULTADES EN LA EVALUACIÓN DE PROGRAMAS... 31

1.6.1 Patologías generales y abusos de la evaluación como síntesis de las problemáticas-dificultades ...36

1.6.2 Algunas alternativas para la superación de las dificultades-problemáticas en el proceso de evaluación.-...38

1.1 Dimensiones de la evaluación.-

Es necesario considerar, aunque sea a título indicativo la concepción que sobre la evaluación tenemos. En este caso solamente haremos alusión a la definición que a lo largo de todo el texto implicamos. Con independencia de otras tantas definiciones previas que podrían justificarla (Tejada, 1997:244-246), conceptualizamos la evaluación como:

* un proceso sistemático de recogida de información, no improvisado,

necesitado de organizar sus elementos, sistematizar sus fases, temporalizar sus secuencias, proveer los recursos, construir o seleccionar los instrumentos, etc. En cualquier caso, desde planteamientos multivariados en cuanto a los instrumentos, técnicas y métodos, así como agentes.

* que implica un juicio de valor, que significa, a su vez, que no basta recoger sistemáticamente la información, sino que ésta ha de valorarse, explicando su bondad. Téngase en cuenta que la adjudicación de un valor no significa tomar decisiones, por cuanto los evaluadores pueden realizar esta tarea y otras personas, ajenos a ellos, pueden tomar las decisiones. Queremos decir, que la función principal del evaluador está en la valoración, pero no necesariamente en la toma de decisiones que puede corresponder a los responsables del programa o de los objetivos a evaluar, políticos, u otros.

* orientada hacia la toma de decisiones. El proceso evaluativo ha de tener una utilidad, en este sentido apuntamos entre otros a la toma de decisiones orientada a la mejora de la práctica. Esto significa además, que la evaluación ha de ser un medio pero no un fin en sí misma.

Ubicados en esta conceptualización, nos abocamos a la aplicación de la evaluación. Esto exige reparar en múltiples dimensiones y variables, su selección y su priorización, en un proceso que mezcla planteamientos desde lo epistemológico, lo ideológico, hasta lo técnico. Por lo tanto, realizar una evaluación implica previamente planificar dicha acción y elaborar el diseño pertinente en relación con la realidad a evaluar. Por ello, se torna necesario reparar en las dimensiones afectadas.

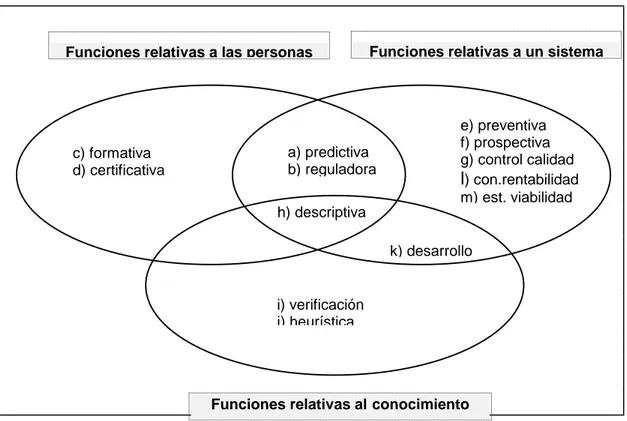

Un primer acercamiento a las dimensiones afectadas en la evaluación educativa se concreta en el ideograma que presentamos (Gráfico 1). Un comentario sucinto del mismo nos indica que:

¿QUE? OBJETO ¿PARA QUÉ? FINALIDAD Contexto Necesidades Objetivos Contenidos Instituciones ¿CÓMO? MODELO Diagnóstica Formativa Sumativa Profesores Alumnos Metodología Recursos ... EVALUACIÓN Experimental Naturalista Basado en demanda

Basado en costos Toma de decisiones

Verificación logros ... Cuantitativa Cualitativa ... ¿CUÁNDO? MOMENTO Inicial Continua Final Diferida Observación Entrevistas Cuestionarios Tests Pruebas Objetivas Escalas ... Validez Fiabilidad Profesores Alumnos Equipo directivo ... Usuario Experto ... Autoevaluación Heteroevaluación

Interna-externa ¿QUIÉN?

EVALUADOR

REFERENTE finalidades definidas por Coherencia con las la política de formación

Pertinencia ...

¿¿CON QUÉ?

INSTRUMENTO

Adecuación a las necesidades formativas

del contexto inmediato

Adecuación a determinados principios

psicopedagógicos

Adecuación a los participantes (necesidades, expectativas,

intereses

Gráfico 1.- Dimensiones básicas de la evaluación educativa (Tejada 1991:88).-

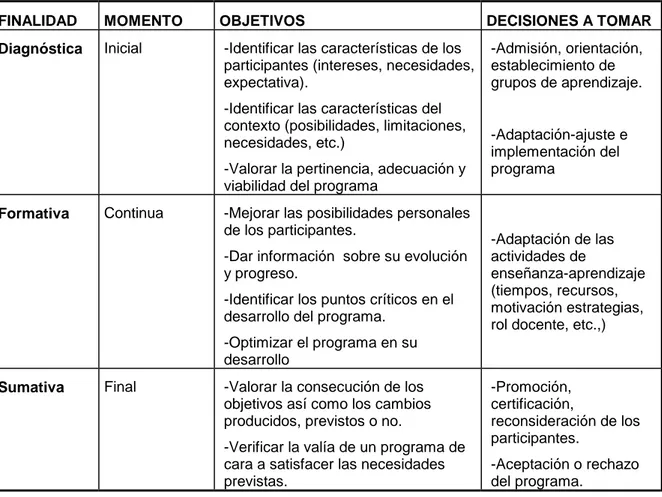

Gráfico 2.- Las funciones de la evaluación (De Ketele y Roegiers, 1995:134)

La evaluación diagnóstica nos permite conocer la realidad en la que operará un programa (evaluación de entrada), tanto en lo relativo al contexto como a los destinatarios del programa; ello nos da pie tanto a posibilitar los recursos y medios necesarios en el contexto para que el programa sea exitoso o bien, teniendo presente las limitaciones contextuales, ajustar el programa a dicho contexto. Por lo que se refiere a los destinatarios nos permite conocer sus necesidades formativas, sus posibilidades para con el programa, etc., lo cual da pie a tomar decisiones sobre admisión, orientación, establecimiento de grupos de aprendizaje según niveles, etc.

La evaluación formativa tiene que ver con el desarrollo del programa (evaluación de proceso) en un contexto determinado y su propósito esta directamente relacionado con la mejora y optimización del mismo en el transcurso de la acción formativa. Permite, pues, el ajuste racional de dicha acción según las vicisitudes que la misma encuentra y afecta básicamente a las estrategias de desarrollo (implementación de nuevos medios y recursos, ajuste de la temporalización -acelerando o lentificando el ritmo previsto, cambio de actividades y papel del formador, etc.)

La evaluación sumativa (evaluación de productos) nos muestra los resultados obtenidos por el programa y en este sentido la toma de decisiones se orienta a la certificación, promoción, en relación con los destinatarios implicados en la acción formativa, a la vez que permite valorar globalmente el programa permitiendo rechazarlo o aceptarlo en función del éxito del mismo.

A continuación expresamos las relaciones e implicaciones entre estas dos últimas dimensiones.

a) predictiva b) reguladora c) formativa

d) certificativa

Funciones relativas a las personas Funciones relativas a un sistema

h) descriptiva

e) preventiva f) prospectiva g) control calidad

l) con.rentabilidad m) est. viabilidad

Funciones relativas alconocimiento i) verificación

j) heurística

FINALIDAD MOMENTO OBJETIVOS DECISIONES A TOMAR Diagnóstica Inicial -Identificar las características de los

participantes (intereses, necesidades, expectativa).

-Identificar las características del contexto (posibilidades, limitaciones, necesidades, etc.)

-Valorar la pertinencia, adecuación y viabilidad del programa

-Admisión, orientación, establecimiento de grupos de aprendizaje.

-Adaptación-ajuste e implementación del programa

Formativa Continua -Mejorar las posibilidades personales de los participantes.

-Dar información sobre su evolución y progreso.

-Identificar los puntos críticos en el desarrollo del programa.

-Optimizar el programa en su desarrollo

-Adaptación de las actividades de

enseñanza-aprendizaje (tiempos, recursos, motivación estrategias, rol docente, etc.,)

Sumativa Final -Valorar la consecución de los objetivos así como los cambios producidos, previstos o no.

-Verificar la valía de un programa de cara a satisfacer las necesidades previstas.

-Promoción, certificación,

reconsideración de los participantes.

-Aceptación o rechazo del programa.

Tabla 1. Relaciones entre finalidad y el momento evaluativo

c) El momento evaluativo, conectado con la finalidad, es otra de las dimensiones básicas. Evaluación inicial con finalidad diagnóstica, al principio de una acción formativa, evaluación continua con finalidad formativa, durante el periodo de formación y evaluación final con finalidad sumativa, al final del periodo de formación. Habría que añadir a estos tres momentos, ya clásicos, la evaluación diferida que en la evaluación de programas toma capital importancia por las repercusiones prácticas y sociales de la misma. Un programa no sólo es bueno por cuanto se verifica la suficiencia de los participantes al final de la acción formativa, sino también por cuanto a lo largo del tiempo tiene una repercusión en la práctica, también denominada evaluación de impacto del programa.

Téngase presente que no siempre se evidencia el paralelismo establecido, por cuanto podemos verificar en la práctica que muchas veces se realiza evaluación continua con finalidad sumativa, en la medida que se recaba información no tanto para optimizar el programa sino más bien sobre el alumno para poderse asegurar mejor en su evaluación final; es decir, se van registrando resultados parciales más que la evaluación del proceso formativo mismo.

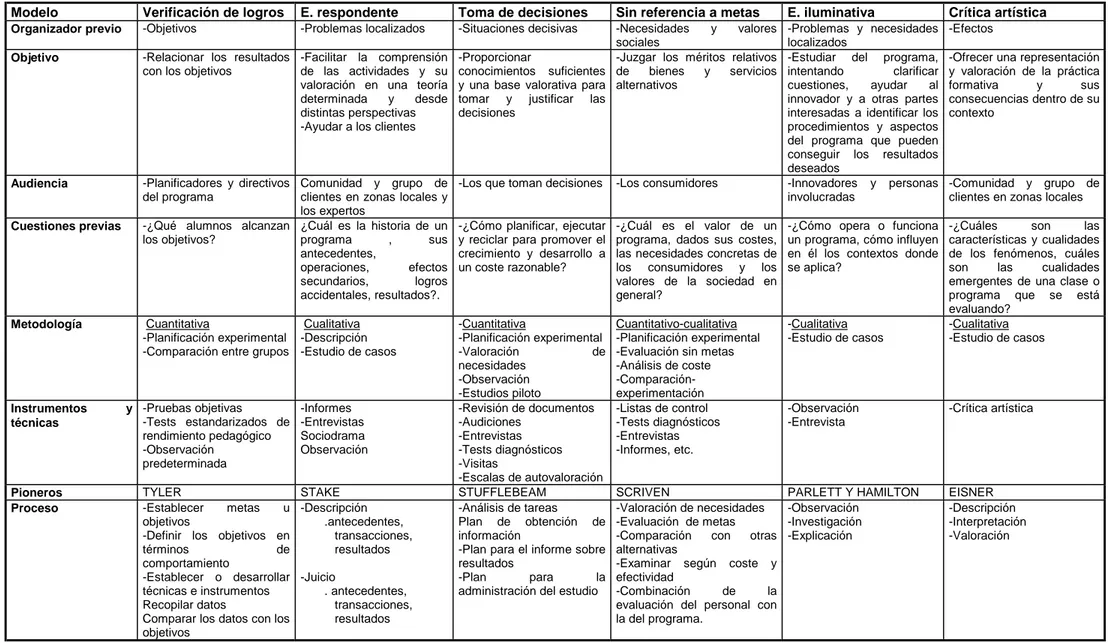

entre los hechos (logros) y los objetivos -modelo de evaluación por objetivos-, la identificación de las necesidades actuales y potenciales de las audiencias, los ideales o valores sociales o el estándar de conocimientos estructurados por los expertos u otros grupos relevantes. El tabla 2 muestra una breve síntesis de los modelos más conocidos en evaluación de programas.

Además, el modelo de interpretación puede basarse en la racionalidad positivista (científico-técnico), en la asignación de valores de la realidad (interpretativo-fenomenológico) o enfatizar el sentido político que adopta cualquier situación (sociocrítico).

e) La instrumentalización nos remite a las herramientas que han de servir para obtener la información considerada como necesaria para la evaluación. Instrumentos y técnicas de recogida de información estructurados, semiestructurados o sin estructurar, susceptibles de tratamientos cuantitativos o cualitativos según el objeto, pero en cualquier caso, válidos, fiables, pertinentes, etc. como características técnicas exigibles a cualquiera de ellos. En una palabra, complementariedad y triangulación de instrumentos.

f) El evaluador se convierte en un eje igualmente importante en el hecho evaluativo. Además de los implicados en el proceso formativo, están los expertos, lo cual nos puede permitir diferenciar entre evaluación interna y evaluación externa, entre heteroevaluación y autoevaluación. Por la relevancia de la problemática generada en torno a esta dimensión, con posterioridad nuevamente repararemos sobre él.

Al margen de las ventajas e inconvenientes de una y otra, suelen combinarse en la práctica y utilizarse como elemento de complementariedad. Con todo, lo que se evidencia cada día con más fuerza es la necesidad de capacitación técnica para poder evaluar. El conocimiento de técnicas, instrumentos, metodologías, etc. en aras de una pretendida "objetividad" (intersubjetividad) es un requisito formativo para los protagonistas de la evaluación.

Modelo Verificación de logros E. respondente Toma de decisiones Sin referencia a metas E. iluminativa Crítica artística

Organizador previo -Objetivos -Problemas localizados -Situaciones decisivas -Necesidades y valores sociales

-Problemas y necesidades localizados

-Efectos

Objetivo -Relacionar los resultados con los objetivos

-Facilitar la comprensión de las actividades y su valoración en una teoría determinada y desde distintas perspectivas -Ayudar a los clientes

-Proporcionar

conocimientos suficientes y una base valorativa para tomar y justificar las decisiones

-Juzgar los méritos relativos de bienes y servicios alternativos

-Estudiar del programa, intentando clarificar cuestiones, ayudar al innovador y a otras partes interesadas a identificar los procedimientos y aspectos del programa que pueden conseguir los resultados deseados

-Ofrecer una representación y valoración de la práctica formativa y sus consecuencias dentro de su contexto

Audiencia -Planificadores y directivos del programa

Comunidad y grupo de clientes en zonas locales y los expertos

-Los que toman decisiones -Los consumidores -Innovadores y personas involucradas

-Comunidad y grupo de clientes en zonas locales

Cuestiones previas -¿Qué alumnos alcanzan los objetivos?

¿Cuál es la historia de un programa , sus antecedentes,

operaciones, efectos secundarios, logros accidentales, resultados?.

-¿Cómo planificar, ejecutar y reciclar para promover el crecimiento y desarrollo a un coste razonable?

-¿Cuál es el valor de un programa, dados sus costes, las necesidades concretas de los consumidores y los valores de la sociedad en general?

-¿Cómo opera o funciona un programa, cómo influyen en él los contextos donde se aplica?

-¿Cuáles son las características y cualidades de los fenómenos, cuáles son las cualidades emergentes de una clase o programa que se está evaluando?

Metodología Cuantitativa

-Planificación experimental -Comparación entre grupos

Cualitativa -Descripción -Estudio de casos

-Cuantitativa -Planificación experimental -Valoración de necesidades -Observación -Estudios piloto Cuantitativo-cualitativa -Planificación experimental -Evaluación sin metas -Análisis de coste -Comparación-experimentación

-Cualitativa -Estudio de casos

-Cualitativa -Estudio de casos

Instrumentos y técnicas

-Pruebas objetivas

-Tests estandarizados de rendimiento pedagógico -Observación predeterminada -Informes -Entrevistas Sociodrama Observación

-Revisión de documentos -Audiciones

-Entrevistas -Tests diagnósticos -Visitas

-Escalas de autovaloración

-Listas de control -Tests diagnósticos -Entrevistas -Informes, etc. -Observación -Entrevista -Crítica artística

Pioneros TYLER STAKE STUFFLEBEAM SCRIVEN PARLETT Y HAMILTON EISNER

Proceso -Establecer metas u objetivos

-Definir los objetivos en

términos de comportamiento

-Establecer o desarrollar técnicas e instrumentos Recopilar datos

Comparar los datos con los objetivos -Descripción .antecedentes, transacciones, resultados -Juicio . antecedentes, transacciones, resultados

-Análisis de tareas

Plan de obtención de información

-Plan para el informe sobre resultados

-Plan para la administración del estudio

-Valoración de necesidades -Evaluación de metas

-Comparación con otras alternativas

-Examinar según coste y efectividad

-Combinación de la evaluación del personal con la del programa.

-Observación -Investigación -Explicación -Descripción -Interpretación -Valoración

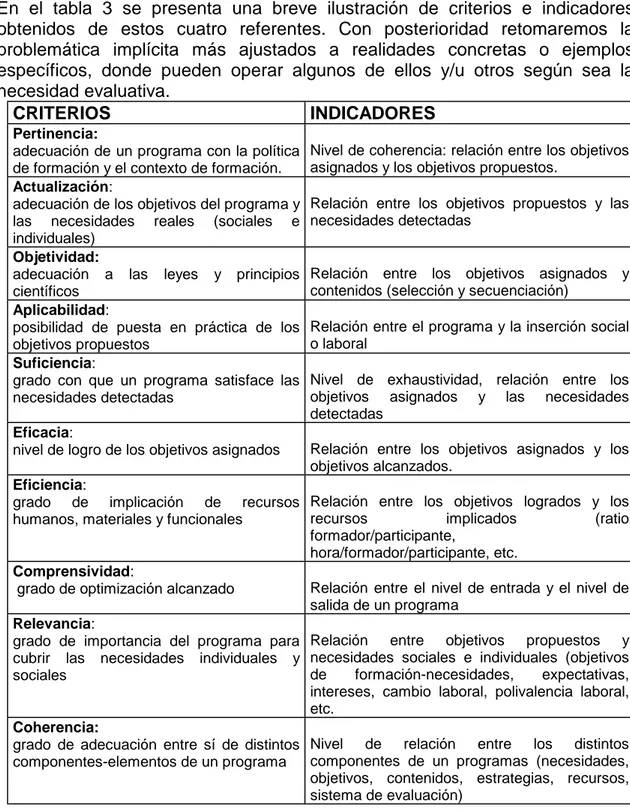

En el tabla 3 se presenta una breve ilustración de criterios e indicadores obtenidos de estos cuatro referentes. Con posterioridad retomaremos la problemática implícita más ajustados a realidades concretas o ejemplos específicos, donde pueden operar algunos de ellos y/u otros según sea la necesidad evaluativa.

CRITERIOS INDICADORES

Pertinencia:

adecuación de un programa con la política de formación y el contexto de formación.

Nivel de coherencia: relación entre los objetivos asignados y los objetivos propuestos.

Actualización:

adecuación de los objetivos del programa y las necesidades reales (sociales e individuales)

Relación entre los objetivos propuestos y las necesidades detectadas

Objetividad:

adecuación a las leyes y principios científicos

Relación entre los objetivos asignados y contenidos (selección y secuenciación)

Aplicabilidad:

posibilidad de puesta en práctica de los objetivos propuestos

Relación entre el programa y la inserción social o laboral

Suficiencia:

grado con que un programa satisface las necesidades detectadas

Nivel de exhaustividad, relación entre los objetivos asignados y las necesidades detectadas

Eficacia:

nivel de logro de los objetivos asignados Relación entre los objetivos asignados y los objetivos alcanzados.

Eficiencia:

grado de implicación de recursos humanos, materiales y funcionales

Relación entre los objetivos logrados y los

recursos implicados (ratio formador/participante,

hora/formador/participante, etc. Comprensividad:

grado de optimización alcanzado Relación entre el nivel de entrada y el nivel de salida de un programa

Relevancia:

grado de importancia del programa para cubrir las necesidades individuales y sociales

Relación entre objetivos propuestos y necesidades sociales e individuales (objetivos de formación-necesidades, expectativas, intereses, cambio laboral, polivalencia laboral, etc.

Coherencia:

grado de adecuación entre sí de distintos componentes-elementos de un programa

Nivel de relación entre los distintos componentes de un programas (necesidades, objetivos, contenidos, estrategias, recursos, sistema de evaluación)

Tabla 3. Criterios e indicadores de evaluación de programas (Tejada, 1997:255)

La complejidad de la evaluación, pues, se hace evidente a la vista de lo analizado y justifica plenamente la afirmación de que una evaluación nunca es completa en sí misma. Por este motivo, la planificación de la misma tiene que hacer énfasis en la determinación de los aspectos más significativos de cada realidad y momento evaluativo.

Una vez delimitadas las dimensiones de la evaluación, en las que ineludiblemente hemos de reparar, es necesario considerar igualmente algunos aspectos diferenciales en los programas de formación que hacen de los mismos adoptar también distintas decisiones en la planificación de su evaluación, diferenciadas de otros objetos de evaluación, al priorizar unos elementos específicos sobre otros. Todo ello nos remite a una manera peculiar de evaluar, con una problemática distinta por ejemplo, si se tratase de evaluación de centros o alumnos.

Hemos de partir, también en este caso, de un concepto de programa que, con independencia de la polisemia del término en sí mismo, sea operativo y clarificador para seguir avanzando. En aras a la brevedad, asumimos por programa "cualquier propuesta estructurada para producir cambios en las personas que se exponen a ellos" Gairín, 1993:80). Entendiendo como tal "desde un diseño específico para la instrucción de un tema concreto de una materia hasta el plan educativo que comporta el desarrollo de un curso completo; desde la actividad docente de un profesor hasta la organización funcional de uno o varios centros educativos; desde un proyecto experimental de enseñanza hasta todo un sistema educativo formal" (Cabrera, 1987:101).

En este contexto particular, pues, la evaluación de programas ha de moverse y como tal la consideramos como aquel proceso continuo, sistemático y multidimensional de recogida de información relevante, válida y fiable que permite tomar decisiones sobre el valor o mérito del mismo para mejorar su funcionamiento.

Dichas decisiones, según Cabrera (1987:113-114), se refieren a distintos ámbitos y pueden concretarse en:

* acerca de la implantación del programa

* relativas a la continuación, expansión o certificación del éxito del programa

* relacionadas con las modificaciones a introducir en el programa en desarrollo.

Además, hay que tener presente y como consecuencia de lo anterior, que existen unas razones que justifican por sí mismas la evaluación de programas:

• cumplimiento de los requisitos de acreditación (cualificación personal) • rendir cuentas (justificación de la inversión, costos)

• demandas de información

• elección-selección del mejor programa (satisfacer necesidades) • asistir al equipo de gestión del programa en su desarrollo y mejora • aprender-verificar acerca de los efectos secundarios (lo no planificado)

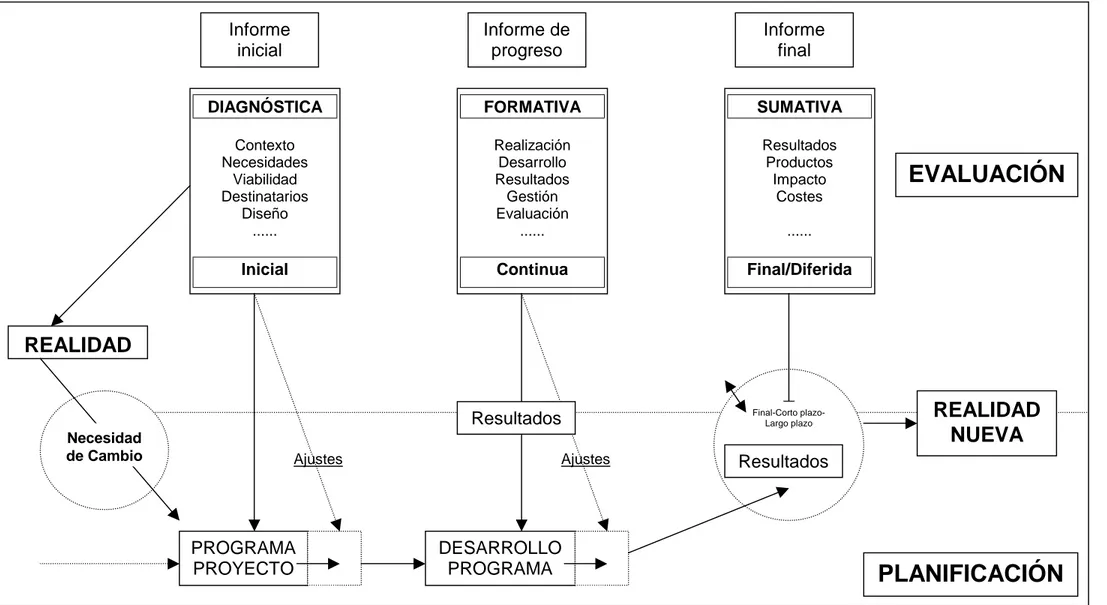

Gráfico 3.- Relación entre el nivel de planificación y evaluación de un programa DIAGNÓSTICA

Contexto Necesidades

Viabilidad Destinatarios

Diseño ...

Inicial

Informe inicial

PROGRAMA PROYECTO

Ajustes

FORMATIVA

Realización Desarrollo Resultados

Gestión Evaluación

...

Continua

Informe de progreso

DESARROLLO PROGRAMA

Ajustes

SUMATIVA

Resultados Productos

Impacto Costes

...

Final/Diferida

Informe final

REALIDAD

EVALUACIÓN

Resultados

PLANIFICACIÓN

REALIDAD

NUEVA

Final-Corto plazo-Largo plazo Necesidad

de Cambio

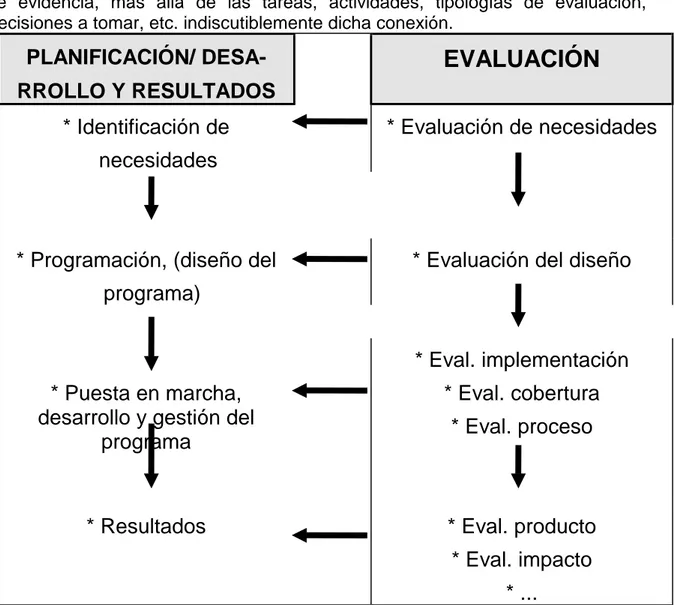

se evidencia, más allá de las tareas, actividades, tipologías de evaluación, decisiones a tomar, etc. indiscutiblemente dicha conexión.

PLANIFICACIÓN/ DESA-

RROLLO Y RESULTADOS

EVALUACIÓN

* Identificación de

necesidades

* Evaluación de necesidades

* Programación, (diseño del

programa)

* Evaluación del diseño

* Puesta en marcha,

desarrollo y gestión del

programa

* Eval. implementación

* Eval. cobertura

* Eval. proceso

* Resultados

* Eval. producto

* Eval. impacto

* ...

Gráfico 4.- Relación entre planificación y evaluación de programas

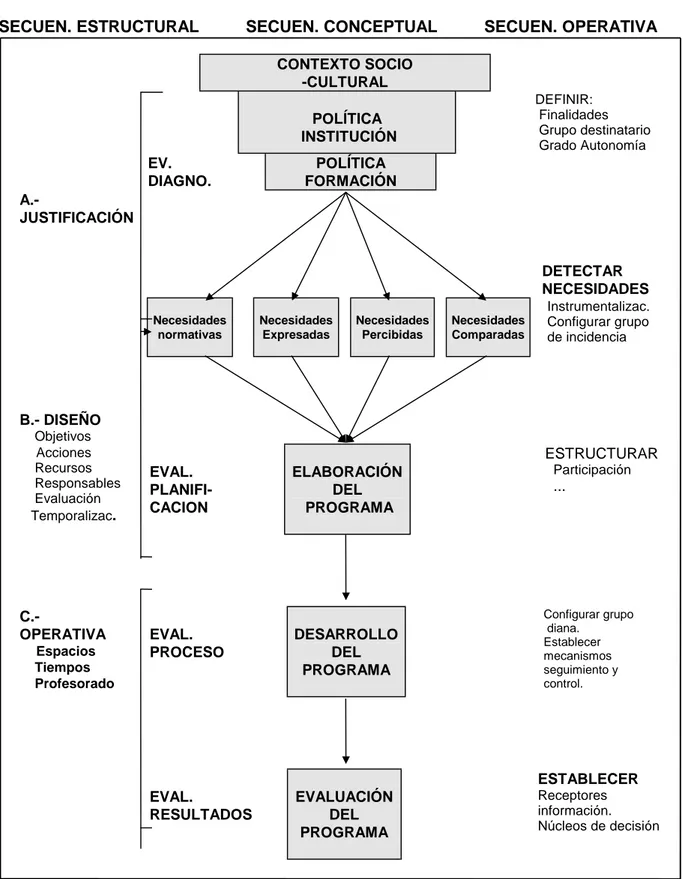

Como puede observarse, ya se están apuntando los focos de atención en la evaluación de programas, no obstante es necesario profundizar aún más en la conceptualización del programa, por cuanto nos puede iluminar en dicho proceso evaluativo. De hecho, como destaca Gairín (1993:82-83), la evaluación de programas es en gran medida deudora de la manera como se confeccionaron y de las concepciones implícitas o explícitas que asumen. En este sentido es clarificadora la secuencia conceptual que nos propone el mismo autor, que en síntesis nos remite a:

• Realidad sociocultural, política institucional y política de formación mantienen entre sí un alto nivel de coherencia. De hecho, afirma, las instituciones y los programas que realizan suelen responder habitualmente a las necesidades socioculturales, de la misma forma que la política de formación se considera un aspecto de la política institucional.

etc.), determina claramente el tipo de objetivos que ha de perseguir el programa, las acciones a realizar y la naturaleza de los procesos de intervención.

SECUEN. ESTRUCTURAL SECUEN. CONCEPTUAL SECUEN. OPERATIVA

CONTEXTO SOCIO -CULTURAL

POLÍTICA INSTITUCIÓN

DEFINIR: Finalidades Grupo destinatario Grado Autonomía

EV. DIAGNO.

POLÍTICA FORMACIÓN A.-

JUSTIFICACIÓN

DETECTAR

NECESIDADES

Necesidades normativas

Necesidades Expresadas

Necesidades Percibidas

Necesidades Comparadas

Instrumentalizac. Configurar grupo de incidencia

B.- DISEÑO

Objetivos

Acciones Recursos Responsables Evaluación Temporalizac.

EVAL. PLANIFI-CACION

ELABORACIÓN DEL PROGRAMA

ESTRUCTURAR Participación

...

C.-

OPERATIVA Espacios Tiempos Profesorado

EVAL. PROCESO

DESARROLLO DEL PROGRAMA

Configurar grupo diana.

Establecer mecanismos seguimiento y control.

EVAL.

RESULTADOS

EVALUACIÓN DEL PROGRAMA

ESTABLECER

Receptores información. Núcleos de decisión

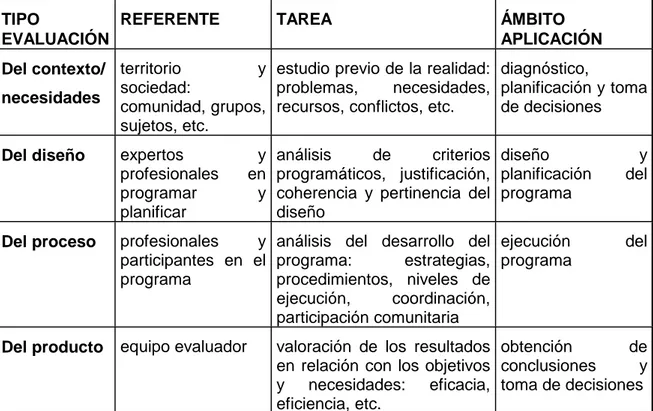

1.3 El proceso de evaluación de programas.-

El proceso de evaluación está estrechamente vinculado con el conjunto de las fases que integran un programa de formación. Es más, la evaluación empieza antes que un programa se implemente, en estrecha relación con todas las actividades de planificación; es decir, empieza cuando han sido realizados los juicios sobre la deseabilidad, necesidad del programa, cuando a partir de análisis de necesidades se establece la política de formación en la institución formativa y consecuentemente se establecen los planes y programas de formación, así como sus objetivos, contenidos, actividades, recursos, etc. (Tejada 1989:90).

TIPO

EVALUACIÓN

REFERENTE TAREA ÁMBITO

APLICACIÓN

Del contexto/

necesidades

territorio y sociedad:

comunidad, grupos, sujetos, etc.

estudio previo de la realidad: problemas, necesidades, recursos, conflictos, etc.

diagnóstico,

planificación y toma de decisiones

Del diseño expertos y profesionales en programar y planificar

análisis de criterios programáticos, justificación, coherencia y pertinencia del diseño

diseño y planificación del

programa

Del proceso profesionales y participantes en el programa

análisis del desarrollo del programa: estrategias, procedimientos, niveles de ejecución, coordinación, participación comunitaria

ejecución del programa

Del producto equipo evaluador valoración de los resultados en relación con los objetivos y necesidades: eficacia, eficiencia, etc.

obtención de conclusiones y toma de decisiones

Tabla 4.- Estructura metodológica de la evaluación en el desarrollo comunitario (Caride 1990)

rediseño del programa, en los procedimientos, actividades, recursos y estrategias, etc. de cara a conseguir los objetivos establecidos.

Tabla 5.- Esquema básico de las implicaciones del proceso de evaluación de un programa

Respecto a su desarrollo, no sólo tendremos en cuenta el logro de los objetivos planteados, siendo estos importantes, sino que interesarán igualmente los procesos seguidos en su implementación, si se han introducido en el transcurso del mismo modificaciones o mejoras, los cambios de actitudes tanto en los formadores como en los participantes, etc. Con ello estamos apuntando claramente los dos componentes de la evaluación formativa, valorando la discrepancia entre lo diseñado y la realidad, por un lado; y la valoración del propio proceso instructivo mientras se realiza, el progreso hacia los objetivos, etc. De esta forma, continua y racionalmente estamos tomando decisiones sobre el diseño o rediseño del programa en aras a su optimización.

Por último, ha de repararse sobre los resultados del programa una vez concluido, si se han conseguido los objetivos -verificación de logros- de cara a acreditar, certificar, etc. (evaluación sumativa) en relación con los alumnos, y también tomar las decisiones necesarias sobre el programa de cara a su perfeccionamiento con el correspondiente rediseño. El objetivo principal, pues, de esta evaluación final y sumativa como indica Cabrera (1987:123) es proporcionar evidencias objetivas, sistemáticas y completas del grado en que el programa ha conseguido los fines que se proponía y el grado en que se han producidos otras consecuencias no

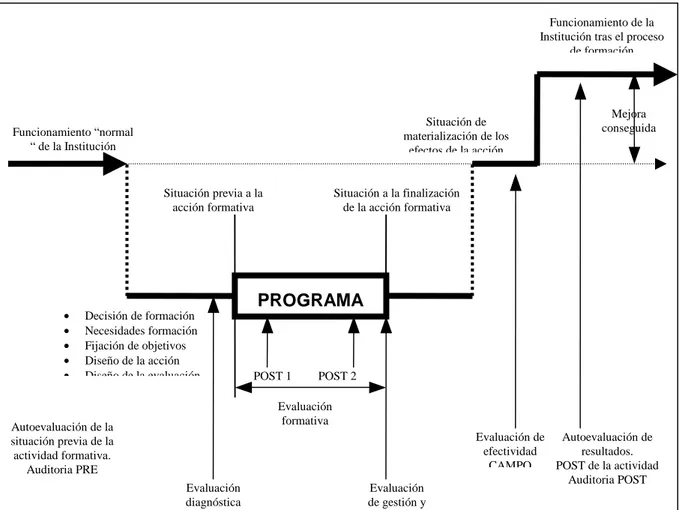

PROGRAMA

Funcionamiento “normal “ de la Institución

Funcionamiento de la Institución tras el proceso

de formación

Situación de materialización de los

efectos de la acción

Autoevaluación de la situación previa de la actividad formativa.

Auditoria PRE

• Decisión de formación

• Necesidades formación

• Fijación de objetivos

• Diseño de la acción

• Diseño de la evaluación

Mejora conseguida

Situación previa a la acción formativa

Situación a la finalización de la acción formativa

Evaluación diagnóstica

PRE

Autoevaluación de resultados. POST de la actividad

Auditoria POST Evaluación

formativa

Evaluación de gestión y de eficcia

Evaluación de efectividad

CAMPO POST 2

previstas, que una vez conocidas, sean también de interés para los responsables y organizadores del programa.

Pero con ello no habríamos finalizado el proceso evaluativo. No bastaría con la evaluación sumativa una vez concluido el programa. Habría que asegurar también con una evaluación diferida, a corto-medio-largo plazo, la permanencia y consistencia de los cambios producidos en los sujetos, la mejora de las prácticas profesionales, los cambios institucionales, etc. según las metas del plan de formación. La evaluación de los impactos del programa nos permitirá concluir sobre la eficacia, eficiencia, comprensividad, validez y utilidad del programa, así como sobre su rentabilidad profesional o social, según fuera el caso.

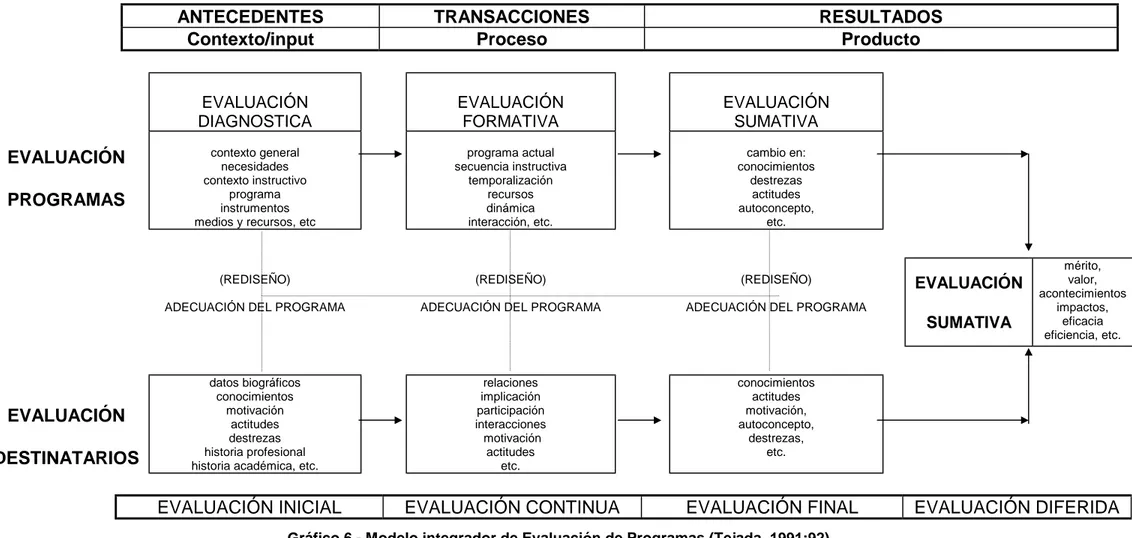

En cierta forma, estamos apuntando por un modelo de evaluación, cuya representación gráfica reflejamos a continuación. Modelo que indiscutiblemente integra elementos de otros modelos en la línea de los expuesto por Hamm (1988:404-408) y que nosotros revisamos.

Como puede observarse, se integran elementos de los modelos de Scriven, Stake y Stufflebeam. Los componentes de evaluación, tanto por lo que se refiere a un programa o a los alumnos, quedan divididos en tres fases: antecedentes, transacciones y resultados en la terminología de Stake (1976), con su correlato en la subsiguiente división de contexto, input, proceso y producto de Stufflebeam (1987).

El modelo permite como tal describir las intenciones y los acontecimientos en cualquier fase, a la par que posibilita la toma de decisiones lo más racionalmente posible a los responsables del programa respecto a la planificación y desarrollo del mismo, tanto en lo que se refiere a la determinación de los objetivos como a la determinación de los recursos, deficiencias y obstáculos observados antes y durante su implementación con el consiguiente rediseño del programa.

Con todo ello, estamos asumiendo que no sólo interesan los resultados finales, siendo estos importantes, sino que la implementación y desarrollo de un programa, con las vicisitudes que entraña, cobran capital importancia. Esto nos remite a la consideración de la evaluación formativa y sumativa de Scriven (1967). Estando interrelacionadas, la finalidad de la primera apunta por la optimización del programa, mientras que la segunda nos permite verificar su eficacia, bien sea de una parte o en su totalidad.

Por último, cabe destacar igualmente el planteamiento de objetivos libres descritos por Scriven (1973), en su modelo de evaluación sin referencia a metas. Dentro de este planteamiento, el evaluador que aborda la evaluación de un programa , debe evaluar, al margen de los objetivos del mismo, de manera que pueda considerar todos los resultados del programa y no sólo los establecidos.

ANTECEDENTES TRANSACCIONES RESULTADOS

Contexto/input Proceso Producto

EVALUACIÓN DIAGNOSTICA

EVALUACIÓN FORMATIVA

EVALUACIÓN SUMATIVA

EVALUACIÓN

PROGRAMAS

contexto general necesidades contexto instructivo

programa instrumentos medios y recursos, etc

programa actual secuencia instructiva

temporalización recursos dinámica interacción, etc.

cambio en: conocimientos

destrezas actitudes autoconcepto,

etc.

(REDISEÑO)

ADECUACIÓN DEL PROGRAMA

(REDISEÑO)

ADECUACIÓN DEL PROGRAMA

(REDISEÑO)

ADECUACIÓN DEL PROGRAMA

EVALUACIÓN

SUMATIVA

mérito, valor, acontecimientos

impactos, eficacia eficiencia, etc.

EVALUACIÓN

DESTINATARIOS

datos biográficos conocimientos

motivación actitudes destrezas historia profesional historia académica, etc.

relaciones implicación

participación interacciones motivación actitudes

etc.

conocimientos actitudes

motivación, autoconcepto,

destrezas, etc.

EVALUACIÓN INICIAL EVALUACIÓN CONTINUA EVALUACIÓN FINAL EVALUACIÓN DIFERIDA

1.4 La planificación en la evaluación de programas.-

Este breve repaso del proceso evaluativo nos permite igualmente reparar en la propia planificación de la evaluación, considerada la misma como una necesidad de obligado cumplimiento en aras una mayor racionalidad, objetividad, validez y pertenencia del hecho evaluativo, huyendo del libre albedrío o de la improvisación a la hora de acometer la evaluación del programa que está funcionando o como ocurre muchas veces está en sus fases finales.

Planificación que en los términos de Posavac (1989:27-38) hay que acometerla considerando los siguientes puntos:

a.- Identificar la audiencia (personas relevantes, sponsor, director del programa, clientes, destinatarios, etc.)

b.- Ajustar los encuentros preliminares con la audiencia con el propósito de fijar qué tipo de evaluación, para qué y porqué de la misma, quien la realizará, cuando se llevará a cabo y qué fuentes de información serán las relevantes y válidas.

c.- Fijar la evaluabilidad del programa

d.- Revisar la literatura

e.- Determinar la metodología: estrategias, población y muestra, control-comparación, selección-construcción de instrumentos, recogida de datos, etc.

f.- Presentar una propuesta por escrito.

Al margen de las problemáticas que cada uno de los aspectos referidos entraña, así como de su propia operativización, mas que fijar un plan de evaluación de programas específico, preferimos reparar en los distintos tipos de evaluación según el objeto, aportando pautas, procedimientos y criterios generales para tenerlos en cuenta en la planificación de la evaluación de los mismos, ya que cada realidad nos obligará a significar unos aspectos sobre otros, y de la toma de decisiones que hagamos al respecto resultará el plan de evaluación de programas concreto (Mateo, 1994).

Desde un punto de vista operativo, podemos concretar la secuencia a seguir desde la idea del trabajo en equipo, dada la complejidad de dicho proceso y la dificultad para abordarla desde la individualidad. Queremos decir con ello que por muy experto o competente que se sea en evaluación, las exigencias del proceso evaluativo nos manifiesta su insuficiencia y nos obliga al trabajo interdisciplinar, consecuencia de la implicación de diferentes ámbitos y protagonistas. Además de integrar el potencial de los distintos miembros del equipo de evaluación y obtener con ello garantías suficientes para el conjunto de problemáticas que se evidencian en el referido proceso, se advierte con ello también la virtualidad de la triangulación, la intersubjetividad y la complementariedad entre evaluación interna y externa, auto y heteroevaluación. Con posterioridad abordaremos las implicación de este planteamiento.

IMPLICA

1. FORMULACIÓN DE LA EVALUACIÓN

Identificación y precisión de la naturaleza de la evaluación

• Definir la audiencia

• Determinar el propósito

• Identificar los aspectos relevantes

2. VALORACIÓN DE LA

EVALUABILIDAD

Análisis a priori de la credibilidad y utilidad de la evaluación que se va a efectuar.

Reordenación de la misma

• Listado de los

componentes básicos: objetivos, resultados y efectos.

• Elección de los más relevantes.

• Análisis crítico de la

posibilidad de analizarlos a través del estudio

evaluativo

3. PLANIFICACIÓN DE LA EVALUACIÓN

Implementación de la

evaluación •

Elección del modelo

• Determinación de la metodología

4. EJECUCIÓN DE LA EVALUACIÓN

Ejecución del proceso evaluativo

• Elaboración del diseño.

• Recogida de la información.

• Análisis e interpretación de la información.

5. UTILIZACIÓN DE LA EVALUACIÓN

Toma de decisiones a partir de las conclusiones elaboradas en el informe evaluativo y otros

aspectos a considerar

• Informe de evaluación

• Toma de decisiones

6. METAEVALUACIÓN Evaluación de la evaluación

• Elección de los criterios referenciales evaluativos

• Análisis y valoración efectuada en base a dichos objetivos.

Tabla 6.- El proceso de evaluación (a partir de Mateo, 1994:61).

El siguiente ideograma ilustra claramente dicho procedimiento en la evaluación de programas.

Gráfico 7.- Ideograma de flujo en evaluación de programas (a partir de Jiménez, 1996)

DISEÑO

TRABAJO INTERNO TRABAJO DE CAMPO

PRESENTACIÓN

RECOGIDA DE LA INFORMACIÓN

AMPLIACIÓN Y CONTRASTACIÓN

ÚLTIMA PUESTA EN COMÚN SISTEMATIZACIÓN

ORGANIZACIÓN ANÁLISIS DE LA INFORMACIÓN

ANALISIS DE DOCUMENTOS. INSTRUMENTALIZACIÓN

DOCUMENTACIÓN PRESENTACIÓN

COMPROMISO

IDEA DEL PROYECTO

INFORME FINAL

NEGOCIACIÓNR

E F L E X I Ó N

E N

1.5 La instrumentalización en la evaluación de programas

Desde un punto de vista eminentemente práctico, la instrumentalización se erige como una de las facetas o tareas más importantes en el diseño de la evaluación de programas, por cuanto en ella concurren y se integran prácticamente el resto de las dimensiones evaluativas. Es más, se ha evidenciado en la práctica, todo y que se hayan acometido adecuadamente la dimensión conceptual y metodológica, que el olvido o desconsideración de las exigencias que entraña esta dimensión operativa, ha impedido realizar la evaluación del programa.

La importancia de esta dimensión y nuestra preocupación por ella la podemos encontrar en el primer apunte de nuestra definición –proceso sistemático de recogida de información-. Esta consideración nos indica que no toda o cualquier información que podamos obtener es la pertinente para nuestros objetivos o finalidades evaluativas. Es decir, dicha información está en estrecha dependencia de QUÉ queremos evaluar (objeto) PARA QUÉ (finalidad) y e FUNCIÓN DE QUÉ (referente-criterio) lo vamos a hacer básicamente. Dicho de otra forma, la información depende de las necesidades evaluativas derivadas del objeto y de la finalidad, siendo el criterio un operador básico que hay que integrar en este momento, en la línea del segundo y tercer apunte de la definición –implica un juicio de valor orientada a la toma de decisiones-. Las cuestiones de evaluación, pues, con independencia en este momento del instrumento y la fuente de información son la resultante de esta triple integración.

Esta preocupación nos obliga a reparar, aunque sea mínimamente en el objeto, indicadores, criterios y referente evaluativo. Aparte de las consideraciones que ya hemos realizadas sobre cada una de estas dimensiones de la evaluación al comentar nuestro modelo conceptual (hexágono) de evaluación, cabe advertir que el referente (política formativa, contexto de intervención, principios psicopedagógicos de E-A y los propios participantes-destinatarios de la formación) es una fuente tanto de criterios como de indicadores de evaluación en la medida que del mismo se derivan, en parte, las necesidades evaluativas. Estos hay que considerarlos como normas de referencia para valorar el objeto evaluado. Con anterioridad hemos planteado y definido algunos de ellos, de ahí que ahora eludamos mayor profundización en este particular

Los indicadores de evaluación, considerados en este momento como concreciones del objeto, quedan afectados en su selección por el referente y los criterios implicados para la valoración y toma de decisiones y por la propia conceptualización del objeto a evaluar. En consonancia con Gairín (1993:94-95) vendrían a ser la “concreción de un conjunto de fenómenos que definen y delimitan aspectos de un programa, y como elementos que facilitan la determinación de las modificaciones que se producen, resultan ser la parte más definida de la evaluación”. Ello obliga a elegir-seleccionar los más idóneos, al margen de otras consideraciones sobre su utilidad, validez, objetividad, especificidad, transparencia que obviamos en este momento.

ítems dependerá de la tipología del instrumento, (abierto-cerrado) y de los propios destinatarios de los mismos, realizando para ello la imprescindible tarea de acomodación a sus propias características (vocabulario usual, dificultad-sencillez, mecanismo de respuesta, etc.). El siguiente ideograma a partir de Gairín (1993) puede ilustrar claramente lo dicho hasta ahora.

OBJETO INDICADORES CRITERIOS REFERENTES Diseño del programa

Desarrollo del programa

Resultados del programa

Objetivos Contenidos Actividades ...

Estrategias Recursos Clima Implicación ... Logros Impacto Costes

Eficacia Eficiencia Pertinencia Idoneidad Relevancia Objetividad Satisfactoriedad Suficiencia

Política de formación

Contexto Principios

Psicopedagógicos Participantes-Destinatarios

Cuestiones de evaluación

• ¿Los objetivos definidos son relevantes con la política de formación?

• ¿Los objetivos formulados son suficientes para satisfacer las necesidades de los destinatarios?

• ¿La selección de contenidos es pertinente con el contexto?

• ¿La metodología permite la participación activa?

• ¿La duración de las sesiones se adecua a las necesidades del contexto?

• ¿Las prácticas realizadas satisfacen las necesidades de los participantes?

• ¿Nivel de los objetivos logrados?

• ¿Satisfacción de las expectativas de los participantes?

• ¿Nivel de cambio producido en la práctica profesional?

• ¿Suficiencia del presupuesto asignado? ...

INSTRUMENTO

Abierto Extenso ... Cerrado Limitado ...

Gráfico 8.- Proceso de instrumentalización

1.6 Problemáticas-dificultades en la evaluación de programas

Venimos sosteniendo en este capítulo inicial que la evaluación es un proceso susceptible de planificación, que entraña organizar los distintos elementos, sistematizar las fases en su desarrollo, temporalizar las secuencias planificadas y proveer los recursos necesarios para que la misma pueda llevarse a cabo.

Todo ello supone, además de vencer las resistencias-obstáculos-dificultades que genera su organización y su desarrollo, proveer de un organigrama evaluativo (asignación de tareas y responsabilidades, competencia técnica) y propiciar los instrumentos, técnicas y metodologías idóneas en cada momento, dentro de un modelo, ajustado y coherente con los propósitos evaluativos.

Es en este contexto de referencia en el que queremos ubicarnos a la hora de analizar las problemáticas y dificultades que entraña el proceso de evaluación, tanto en su planificación como en su realización práctica. Se trata con ello de evidenciar los elementos que deben ser objeto de atención en el proceso de configuración y desarrollo de la evaluación y no tanto el justificar la dificultad de la misma.

Conviene en primer lugar, antes de empezar y sin pretender ser exhaustivos, tener un marco de referencia sobre el proceso de evaluación en el ámbito de la evaluación de programas (aunque el mismo sea extrapolable a otros ámbitos: centros, profesores, alumnos,...). Para ello retomaremos nuevamente, por ser suficientemente ilustrativa, la síntesis que nos ofrece Mateo (1994:61) sobre el proceso de evaluación, teniendo presente las fases, propósitos y actividades que implica.

Cabe considerar en este momento que las posibles dificultades en el proceso de evaluación de programas nos remiten a los conceptos ya acuñados de la evaluación de la evaluabilidad o factibilidad de la evaluación, de tal forma que, aunque las respuestas no puedan ser genéricas, en situaciones de graves dificultades, la puesta en marcha de un programa se pone claramente en entredicho.

También habrá que considerar que los programas son deudores de la forma como se confeccionaron y de los objetivos y finalidades que se les asignaron. Una indefinición de metas o la falta de claridad en las acciones que el propio programa plantea es lógico que sean una fuente de problemáticas y, en último extremo, una dificultad para la evaluación.

Al referirnos a las problemáticas en la evaluación de programas, estamos aludiendo a aquellos obstáculos que podemos encontrar a lo largo del proceso evaluativo, que afectan tanto a la viabilidad, factibilidad y utilidad de la misma, y, por tanto, repercuten en el proceso de recogida de información, la emisión del juicio de valor y en la consecuente toma de decisiones.

GENERALES • Teórico-conceptuales • Sustantivas

• Metodológicas

ESPECÍFICAS • Diseño-implementación del programa

• Diseño de evaluación • Desarrollo de la evaluación • El evaluador/res como problema • Los destinatarios y su participación

Tabla 7.- Clasificación de las problemáticas-dificultades

1.- Problemáticas-dificultades generales:

En este sentido, cabe diferenciar tres tipos: a) teórico-conceptuales, b) sustantivos y c) metodológicos.

a) Problemáticas teórico-conceptuales: Hacen referencia al concepto de evaluación y de programas que se utiliza y que justifica diferentes enfoques que en la práctica se adoptan.

⇒ En primer lugar, hemos de referir una problemática global que se deriva del abordaje paradigmático marcadamente exclusivista. Queremos decir que la evaluación, en la línea de lo expuesto por Anguera (1990:83), tiene un carácter científico y que puede considerarse como una debilidad teórico-conceptual abordarla exclusivamente desde un sólo paradigma. Todos, en síntesis, pueden ser complementarios. El posicionarse en uno u otro afecta sobre todo al tipo de decisiones que pueden tomarse en relación con las metodologías, instrumentos y técnicas de evaluación, así como el papel del evaluador y a las finalidades evaluativas.

⇒ Considerar la planificación y la evaluación como esquemas sucesivos y no simultáneos e interrelacionados: Así, como ejemplo, si la planificación conlleva la identificación de necesidades o problemas, la evaluación aporta procedimientos para detectarlos o, si se establece el plan de actuación, la evaluación analiza la conceptualización subyacente y la lógica del programa de intervención.

⇒ Diferenciar el proceso de recopilación y análisis de la información del proceso de valoración.

⇒ Presentar como perspectivas contrapuestas la evaluación de procesos y la evaluación de resultados o como sinónimos la evaluación formativa y la evaluación de desarrollo.

b) Problemáticas sustantivas:

⇒ Falta algún elemento en el diseño de evaluación: no se considera el presupuesto, los recursos necesarios, etc.

⇒ Ambigüedad en la definición de los elementos, lo son de manera muy general, de tal forma que se hace difícil evaluar la factibilidad de la evaluación por la falta de concreción.

⇒ Incoherencia interna en el plan de evaluación; esto es, los elementos considerados no se subordinan a los mismos objetivos, no se contemplan todas ala actuaciones necesarias, la metodología es incoherente con la naturaleza del objeto a evaluar o con los recursos existentes, la temporalización no la imposibilidad de simultanear acciones, etc.

⇒ Inexistencia de mecanismos de control para evaluar los efectos “no previstos” y “no previsibles”.

c) Problemáticas metodológicas:

Tienen que ver específicamente con la metodología a usar en el propio proceso. En este ámbito podemos referir:

⇒ debilidad metodológica en los diseños-modelos de evaluación, resultante de la falta de experiencia en evaluación. Se verifica, además, en la práctica, que la misma está en relación o en consonancia con la

competencia profesional en función de la formación metodológica que poseen los evaluadores.

⇒ No se aplican criterios de validez, fiabilidad y pertinencia, particularmente los referidos a la determinación de la población y muestra de estudio y los instrumentos de medida, que afectan a la validez interna y externa de la propia evaluación.

⇒ la falta de tradición o cultura evaluativa. Consideramos, en todo caso, que la evaluación como tal es joven, de ahí sus problemas. En la medida que se incremente la cultura evaluativa, y exista experiencia, más allá de lo burocrático, en la evaluación, estas dificultades irán menguando, posibilitándose a través de dicha experiencia recursos para mejorar y superar la debilidad metodológica.

2.- Problemáticas-dificultades específicas:

Teniendo presente las problemáticas generales, ya planteadas, presentamos a continuación algunas otras específicas, con carácter complementario, y con el objetivo de concretar aún más el proceso de evaluación desde esta óptica. En este caso las organizamos también de acuerdo al programa, al propio proceso de evaluación, para detenernos por último en los implicados en la evaluación.

a) Diseño e implementación del programa:

Como destaca Anguera (1990:85) afectan a la factibilidad de la propia evaluación. En este particular, destacamos en consonancia con la autora referida:

⇒ Fines-objetivos generales no realistas-ilusorios-utópicos, por no atender a las necesidades que ha de satisfacer el programa.

⇒ Falta de claridad en las tareas a realizar.

⇒ Inexistencia de organigrama de secuenciación de las acciones. ⇒ Falta de calendario o previsión temporal (cronograma).

⇒ Falta de monitorización-asesoramiento de los ejecutores del programa.

b) Diseño de la evaluación:

Básicamente afectan a su estructura y a la naturaleza de los elementos que en él quedan definidos (Gairín, 1992:225). Se pueden concretar en:

⇒ Falta de la consideración del contexto y de los grupos destinatarios. ⇒ No partir del análisis de las demandas.

⇒ Falta de participación de los protagonistas (usuarios, técnicos, responsables, “esponsors”, etc.).

⇒ Delimitación de objetivos deficientes (ambiguos, contradictorios o utópicos).

⇒ Actuaciones no secuenciadas o excesivamente genéricas. ⇒ Ausencia de cronograma o previsión temporal.

⇒ No explicitación de los recursos necesarios.

⇒ Ausencia de organigrama o responsables del proceso (diferenciación funcional).

Dado que estas problemáticas son estructurales, su modificación aumentaría la validez interna del diseño, por contra, su presencia resta credibilidad a la propia evaluación.

c) Desarrollo de la evaluación:

Tienen que ver con la ejecución de la evaluación. En esta fase podemos encontrar:

⇒ Errores sistemáticos no previsibles de localización de destinatarios, problemas sobre la cumplimentación de protocolos, desfases temporales, mortandad experimental, etc.

⇒ No someter el proceso de evaluación a control, ya sea contrastando las fuentes de información o evaluando el mismo proceso (metaevaluación). ⇒ Realización del informe parcializado, sin fundamentarlo adecuadamente a

las conclusiones (se olvidan los límites que han existido, se ignorar los efectos secundarios o se basa la información en una sola persona o se contaminan las valoraciones con sentimientos personales.

d) El evaluador/es como problema.

En este caso, los principales problemas que se presentan son:

⇒ la falta de competencia metodológica del propio evaluador. Este necesita una formación específica para acometer las tareas que implica tanto el diseño-planificación como la ejecución de la evaluación. Además, aunque exista tal competencia, no siempre es una garantía para una evaluación de calidad, sobre todo desde la óptica de la evaluación externa como veremos.

⇒ la relación entre evaluadores y las demás personas implicadas en el hecho evaluativo ("esponsors", docentes, gestores, etc. y la derivada de la complementariedad entre evaluación interna y evaluación externa, para evitar el sesgo unidireccional que puede producirse cuando se acometen evaluaciones exclusivamente desde una u otra óptica. Los primeros generan recelos, temores, suspicacias, con sus consabidas repercusiones sobre la aceptación o inhibición de los segundos. Además, al no estar implicados en el programa, no conocer todas las dimensiones y dinámicas subyacentes que se originan o presentan durante el desarrollo del mismo. Los segundos, por contra, dada su implicación afectiva, tienen “falta de miras”, y deficiencias para evaluar por estar dedicando sus energías a otros quehaceres, no propiamente evaluativas.

e) Los destinatarios y su participación. La participación en los procesos de evaluación es hoy día una exigencia técnica (aporta validez a las variables, preguntas, indicadores y criterios) y social (necesaria como garantía de la utilidad y aplicabilidad de lo obtenido) pero no por ello ha de incidir en el intercambio de papeles (Gairín, 1992:224).

Además de todo lo apuntado en el apartado anterior, existen puntos de fricción entre los implicados en los procesos de evaluación que hay que tener presentes igualmente como problemáticas y dificultades del propio proceso y que se pueden concretar en torno a:

⇒ Diferencias de personalidad entre evaluadores, responsables, gestores, etc. (evaluadores, como asépticos, neutrales, responsables-gestores como extrovertidos, etc.)

⇒ Falta del diferenciación funcional (o de papeles en el propio proceso) entre responsables, gestores, ejecutores, evaluadores.

⇒ Falta de definición nítida de los distintos papeles en el proceso.

⇒ Metas, valores, intereses, expectativas y marcos de referencia en conflicto. ⇒ Características institucionales (larga/corta historia, experiencia, conflictos

institucionales, cultura, clima organizacional, etc.).

Estos puntos de fricción se pueden concretar en acciones-tareas del proceso que igualmente quedan afectadas en su desarrollo. En este sentido sencillamente queremos puntualizar en torno a:

⇒ Cambios en los procedimientos para llevar registros (falta de univocidad de criterios).

⇒ Selección de los participantes en el programa.

⇒ Elección de grupos (muestra: grupos experimentales y controles). ⇒ Retroalimentación de la información en el programa.

⇒ Rivalidad de rango

Ante tales situaciones no es de sorprender la presencia de las resistencias en los afectados por la evaluación. Resistencias, consubstanciales al propio proceso, que pueden concretarse entre otras por:

⇒ Miedo que las evaluaciones impidan el desarrollo del programa ⇒ Miedo a que el programa finalice.

⇒ Miedo a que la información puede ser abusiva, engañosa, mal utilizada, etc.

⇒ Miedo a que se agoten los recursos del programa.

⇒ Miedo a que la comprensión cualitativa del proceso pueda ser suplantada ⇒ Miedo a pérdida de control del programa.

⇒ Miedo a que la evaluación tenga escaso impacto

Las mismas pueden patentizarse de distintas formas, entre otras destacamos la falta de colaboración en la evaluación por parte de los usuarios-afectados, bien sea por recelo u otras motivaciones, pero que posibilitan una información sesgada o rechazo directo, no cumplimiento de protocolos o cualquier instrumento. etc.

1.6.1 Patologías generales y abusos de la evaluación como síntesis de las problemáticas-dificultades

Este breve análisis nos permite llegar a las patologías de la evaluación, bien ilustradas por Santos Guerra (1993:15-31) y que de manera sintética podemos apuntar:

♦ Ev. unilateralmente (alumnos, resultados, conocimientos...) ♦ Ev. lo explícito, lo observable.

♦ Ev. negativamente

♦ Ev. descontextualizadamente

♦ Ev. lo pretendido.

♦ Ev. estereotipadamente (planes, instrumentos...) ♦ Ev. para controlar, para conservar

♦ Ev. sólo interna

♦ Ev. competitivamente

♦ No evaluar éticamente. ♦ No realizar paraevaluación

♦ No realizar metaevaluación

♦ Ev. distemporalmente

♦ No se incluye autoevaluación

♦ No se integran diferentes informaciones.

Tabla 8.- Patologías de la evaluación (Santos Guerra, 1993).

En la misma dirección, podrían considerarse igualmente los abusos de la evaluación, también expuestos por Santos Guerra (1993:45-56):

♦ Convertirla en un elogio a quien la patrocina o la realiza.

♦ Elegir sesgadamente algunas parcelas o experiencias que favorezcan una realidad o una visión de la misma.

♦ Hacer una evaluación de diferente naturaleza y rigor para realidades igualmente importantes.

♦ Convertirla en un instrumento de dominación, control y opresión. ♦ Ponerla al servicio de quienes más tienen o pueden.

♦ Atribuir los resultados a causas más o menos supuestas a través de procesos atributivos arbitrarios.

♦ Encargarla a equipos o personas sin independencia o valor para decir la verdad.

♦ Silenciar los resultados respecto a los evaluador o a otras personas.

♦ Seleccionar aquellos aspectos que permitan tomar decisiones que apoyan las iniciativas, ideas o planteamiento del poder.

♦ Hacer públicas sólo aquellas partes del informe que tienen un carácter halagador.

♦ Descalificar la evaluación achacándole falta de rigor si los resultados no interesan.

♦ Dar por buenos los resultados a pesar de la falta de rigor, cuando esto no es lo que interesa.

♦ Utilizar los resultados para tomas decisiones clara o subrepticiamente injustas.

♦ Atribuir los malos resultados no al desarrollo del programa sino a la torpeza, la pereza o la mala preparación o voluntad de los usuarios del mismo.

Tabla 9.- Abusos de la evaluación (Santos Guerra, 1993)

1.6.2 Algunas alternativas para la superación de las dificultades-problemáticas en el proceso de evaluación.-

Como puede apreciarse, al margen de cualquier comentario específico, la falta de cultura evaluativa se convierte en el principal problema de los procesos evaluativos. Así pues, toda intervención que procure incrementar la cultura evaluativa automáticamente, además de vencer las resistencias a la evaluación, incidirá en la solución de las problemáticas apuntadas. Esto nos remite a insinuar acciones que afecten al conocimiento de la estructura del programa, sus destinatarios, objetivos, contexto de aplicación, recursos, etc.; a la estrecha relación que se ha de establecer entre los evaluadores y los implicados por el programa, bien sean los destinatarios directos de la acción, o bien los responsables del mismo, en aras a la comunicabilidad necesaria para evaluar; al establecimiento de la secuencia temporal, operativa, metodológica e instrumental de la evaluación.

Todo ello incidirá tanto en la objetividad (intersubjetividad), como en factibilidad, viabilidad y utilidad de la evaluación.

De manera más específica podemos precisar:

1. Estudio del diseño del programa: identificando sus componentes y analizando las conexiones entre los mismos (institución que los financia, informes anuales, presupuestos, recursos materiales, personal implicado, contexto de funcionamiento, necesidades que pretende satisfacer, efectos previstos, destinatarios, temporalización, etc.

2. Comprobación del proceso de implementación-desarrollo del programa: recabando información sobre cómo se implementa, quienes son los beneficiarios, quienes son los usuarios -implementadores-, recursos implicados durante el desarrollo, problemáticas, obstáculos y resistencias, seguimiento de la temporalización prevista, etc.

3. Disponer de un plan preciso, claro y negociado sobre la evaluación y su proceso: El mismo debe reflejar con exactitud los objetos de evaluación, finalidades y objetivos (claves para la toma de decisiones), momentos (cronograma evaluativo), instrumentos (válidos, fiables, pertinentes), fuentes de información (documentales o personales) y evaluadores (organigrama funcional).

4. Complementar evaluación interna con la externa: como superadoras de las deficiencias implícitas de cada una de ellas. En el tabla siguiente presentamos las ventajas e inconvenientes de una y otra, asumiendo la complementariedad.

Conocimiento del programa

Conocimiento del contexto aplicación

Experiencia técnica

Implicación afectiva

Evaluación formativa

Evaluación sumativa

+-

+

-

+

+

-

-+

-

+

-

-

+

Tabla 10.- Ventajas e inconvenientes entre evaluación interna-externa

Gráfico 9.- Implicaciones paradigmáticas en la evaluación (Tejada 1995)

6. Disponer de consenso tanto en el diseño como desarrollo de la evaluación entre los implicados en la misma: lo que obliga a las pertinentes reuniones y negociaciones y cuya resultante es la unificación de criterios evaluativos.

7. Trabajar en grupo (equipo de evaluación): superando las limitaciones derivadas de los individualismos. Dada la complejidad del proceso evaluativo es imposible que una única persona sea capaz de acometer con garantías todas las tareas que el mismo entraña. Además, el equipo implica un gran potencial, por cuanto la diferenciación funcional y competencial (si las definiciones de los roles son claras) posibilita mayor riqueza y posibilidades tanto en el diseño, ejecución y toma de decisiones.

8. Propiciar recursos y apoyo por parte de los administradores o directivos: Lo que conlleva consecuencias organizativas -espacio y tiempo para evaluar-. También ello puede afectar a la formación sobre evaluación, como recurso necesario e imprescindible para que la misma sea acometida con posibilidades de éxito.

9. Articular un sistema de retroalimentación del propio proceso, con información útil y válida para la toma de decisiones respecto al seguimiento

Hecho Valor Acción

Toma de decisiones

Medida Valoración

COMPLEMENTARIEDAD

EVALUACION

PROBLEMA PARADIGMÁTICO

y desarrollo del propio plan de evaluación, así como para los propios implicadados tanto en la implementación-desarrollo del programa como en la evaluación del mismo.

10.Incorporar la metaevaluación como herramienta de control y mejora de los procesos de evaluación, dado que la propia complejidad del proceso evaluativo exige este requisito para poderle ser riguroso, contrarrestando los riesgos del mismo y poderle atribuir valor.

En síntesis, queremos concluir en la línea de Santos Guerra (1993:34-35) que estas aproximaciones nos remiten a una evaluación más valiosa que se caracterizaría por:

• Independiente y por ello comprometida. • Cualitativa y no meramente cuantitativa. • Práctica y no meramente especulativa. • Democrática y no autocrática.

• Procesual, no meramente final. • Participativa, no mecanicista. • Colegiada, no individualista.