Dimensionamiento de piezas usando el sistema de visión de la celda de manufactura flexible en la Facultad de Ingeniería Mecánica

Texto completo

(2) DIMENSIONAMIENTO DE PIEZAS USANDO EL SISTEMA DE VISIÓN DE LA CELDA DE MANUFACTURA FLEXIBLE EN LA FACULTAD DE INGENIERÍA MECÁNICA. CARLOS EDUARDO GIRALDO MONTERO. Trabajo de grado presentado como requisito parcial para optar al título de Ingeniero Mecánico. Director Juan Felipe Arroyave M.Sc Ingeniero Mecánico. UNIVERSIDAD TECNOLÓGICA DE PEREIRA FACULTAD DE INGENIERÍA MECÁNICA PEREIRA 2007.

(3) Nota de aceptación. Firma del Director. Firma del Evaluador.

(4) DEDICATORIA El presente trabajo está dedicado a mi familia, la cual me ha servido de soporte a lo largo de estos años y me ha brindado toda la colaboración posible para lograr todas mi metas tanto a nivel personal como profesional. A Adriana quien ha sido mi inspiración y el motor que me impulsa para ser cada día mejor con el fin de forjar un futuro juntos, lleno de éxitos y con mucho amor. Nada de esto hubiera sido posible sin su ayuda incondicional y por eso les agradezco mediante este trabajo..

(5) AGRADECIMIENTOS A los ingenieros Juan Felipe Arroyave y Carlos A. Montilla, por su enorme colaboración durante el desarrollo de este proyecto y por los aportes realizados a este. A los profesores que durante mi proceso de formación me brindaron además de un conocimiento técnico una visión más amplia de la vida y en especial a los ingenieros Marco Tulio Garzón, Manuel Pinzón Candelario, Álvaro Hernán Restrepo y Educardo Roncancio por compartir conmigo sus valiosos conocimientos. A mis amigos que hicieron de mi paso por la Universidad algo inolvidable, en especial a Laura Cristina, Sebastián y Rafael los cuales también aportaron en mi formación como ingeniero y como persona. A todas las personas que conocí y que de alguna u otra forma contribuyeron en la realización del presente trabajo..

(6) CONTENIDO Pág. INTRODUCCIÓN ................................................................................................... 12 OBJETIVO GENERAL ........................................................................................... 13 OBJETIVOS ESPECÍFICOS .................................................................................. 13 JUSTIFICACIÓN .................................................................................................... 14 1.. GENERALIDADES DE LOS SISTEMAS DE VISIÓN ARTIFICIAL ........... 15. 2.. INTRODUCCIÓN AL TRATAMIENTO DIGITAL DE IMÁGENES ............. 18. 2.1. LA IMAGEN DIGITAL ............................................................................... 18. 2.2. PROPIEDADES DE LA IMAGEN DIGITAL............................................... 18. 2.3. TIPOS DE IMÁGENES DIGITALES.......................................................... 19. 2.3.1. Imagen Binaria .......................................................................................... 19. 2.3.2. Imagen de Escala de Grises ..................................................................... 19. 2.3.3. Imagen a Color ......................................................................................... 19. 2.3.4. Imagen Compleja ...................................................................................... 20. 2.4. ANÁLISIS DE LA IMAGEN ....................................................................... 20. 2.4.1. Histograma ............................................................................................... 20. 2.5. PROCESAMIENTO DE LA IMAGEN ........................................................ 21. 2.5.1. LUT ........................................................................................................... 21. 2.5.2. Filtros. ....................................................................................................... 21. 2.6. ANÁLISIS DE PARTÍCULAS .................................................................... 25. 2.6.1. Thresholding ............................................................................................. 26. 2.6.2. Técnicas de Thresholding Automático ...................................................... 27. 3.. TÉCNICAS DE ILUMINACIÓN ................................................................. 31. 3.1. ILUMINACIÓN POSTERIOR .................................................................... 31. 3.2. ILUMINACIÓN FRONTAL......................................................................... 31. 3.3. ILUMINACIÓN LATERAL ......................................................................... 32. 3.4. ILUMINACIÓN POR CAMPO OSCURO ................................................... 32.

(7) 3.5. ILUMINACIÓN COAXIAL .......................................................................... 33. 3.6. ILUMINACIÓN DIFUSA CONTINUA......................................................... 33. 4.. DESCRIPCIÓN DEL SOFTWARE ............................................................ 35. 4.1. LABVIEW .................................................................................................. 35. 4.2. NI IMAQ .................................................................................................... 35. 4.3. IMAQ VISION ........................................................................................... 36. 4.4. VISION ASSISTANT ................................................................................. 36. 4.5. MEASUREMENT & AUTOMATION EXPLORER (MAX) .......................... 36. 5.. DESCRIPCIÓN DEL HARDWARE ........................................................... 37. 5.1. TARJETA DE ADQUISICIÓN IMÁGENES ............................................... 37. 5.2. CÁMARA .................................................................................................. 38. 5.3. CAJA DE LUZ ........................................................................................... 39. 6.. IMPLEMENTACIÓN DE LA APLICACIÓN................................................ 40. 6.1. SELECCIÓN DE LA TÉCNICA DE ILUMINACIÓN ................................... 40. 6.2. ADECUACIÓN DE LA ESCENA ............................................................... 41. 6.3. CALIBRACIÓN DEL SISTEMA ................................................................. 42. 6.4. MODIFICACIONES FINALES ................................................................... 47. 7.. DESCRIPCIÓN DEL PROGRAMA ........................................................... 49. 8.. INCERTIDUMBRE EN LAS MEDICIONES............................................... 54. 8.1. CALCULO DE LA INCERTIDUMBRE TIPO B .......................................... 54. 8.2. CÁLCULO DE LA INCERTIDUMBRE TIPO A .......................................... 57. 9.. RESULTADOS ......................................................................................... 59. 9.1. DATOS OBTENIDOS ............................................................................... 59. 10.. CONCLUSIONES Y RECOMENDACIONES ............................................ 65. BIBLIOGRAFÍA ...................................................................................................... 66.

(8) LISTA DE FIGURAS Pág. Figura 1. Aplicaciones de la visión artificial. ........................................................... 15 Figura 2. Elementos de un sistema de visión......................................................... 16 Figura 3. Referencia Espacial del pixel (0,0) ......................................................... 18 Figura 4. Histograma ............................................................................................. 20 Figura 5. Tipos de escala vertical .......................................................................... 21 Figura 6. Imagen Original ...................................................................................... 23 Figura 7. Efecto de Filtro Gradiente ...................................................................... 23 Figura 8. Efecto del Filtro Laplaciano..................................................................... 24 Figura 9. Imagen Original ...................................................................................... 24 Figura 10. Efecto del Filtro de Suavizado ............................................................. 24 Figura 11. Imagen Original .................................................................................... 25 Figura 12. Efecto del Filtro Gaussiano .................................................................. 25 Figura 13. Imagen Original .................................................................................... 26 Figura 14. Histograma ........................................................................................... 27 Figura 15. Efecto del Thresholding ........................................................................ 27 Figura 16. Thresholding Automático ...................................................................... 28 Figura 17. Iluminación Posterior ............................................................................ 31 Figura 18. Iluminación Frontal................................................................................ 32 Figura 19. Iluminación Lateral ................................................................................ 32 Figura 20. Iluminación por Campo Oscuro ............................................................ 33 Figura 21. Iluminación Coaxial ............................................................................... 33 Figura 22. Iluminación Difusa Continua ................................................................. 34 Figura 23. Tarjeta de Adquisición de imágenes IMAQ PCI 1408 ........................... 37 Figura 24. Cámara CCD MINTRON MS1131C ...................................................... 38 Figura 25. Caja de Luz ........................................................................................... 39 Figura 26. Nivelación de la Caja de Luz ................................................................ 41 Figura 27. Malla de Calibración ............................................................................. 43 Figura 28. Niveles de referencia iniciales .............................................................. 44.

(9) Figura 29. Niveles de referencia finales ................................................................. 44 Figura 30. Cambio del modo de adquisición .......................................................... 45 Figura 31. Malla de calibración .............................................................................. 46 Figura 32. Modificación .......................................................................................... 47 Figura 33. Implementación de la modificación ....................................................... 48 Figura 34. Medición lineal ...................................................................................... 49 Figura 35. Medición Radial .................................................................................... 50 Figura 36. Medición Angular .................................................................................. 50 Figura 37. Mediciones Incorrectas ......................................................................... 51 Figura 38. Incertidumbre angular ........................................................................... 56 Figura 39. Pieza Nº1 .............................................................................................. 60 Figura 40. Pieza Nº2 .............................................................................................. 62.

(10) LISTA DE TABLAS Pág. Tabla 1. Características de la IMAQ PCI 1408 ...................................................... 38 Tabla 2. Características de la cámara MS1131C................................................... 39 Tabla 3. Comparación de las Técnicas de Iluminación .......................................... 40 Tabla 4. Mediciones realizadas.............................................................................. 57 Tabla 5. Medidas realizadas a la Pieza Nº1........................................................... 60 Tabla 6. Mediciones realizadas a la pieza Nº2 ...................................................... 62.

(11) LISTA DE ANEXOS Pág. ANEXO A. MANUAL DE CALIBRACIÓN Y USO ................................................... 67 ANEXO B. TABLA t-STUDENT.............................................................................. 85 ANEXO C. COEFICIENTE DE COBERTURA ....................................................... 86.

(12) INTRODUCCIÓN El uso de la visión artificial se está extendiendo cada día más entre los diferentes sectores industriales, tanto en procesos de control de producto como en control de proceso. La utilización de esta tecnología, y los beneficios que su uso conlleva, se centran principalmente en sectores industriales del metal (automoción, aluminio, acero), y de alimentación (especialmente en procesos de envase). Una aplicación de la visión artificial es en la metrología dimensional, ya que debido a las características especiales de esta tecnología, es adecuada para la obtención y extracción de medidas en 2D y 3D de los objetos en la escena. Posteriormente, estas medidas obtenidas se pueden usar con fines diversos, como el control de calidad entre otros. La Celda de Manufactura Flexible de la Facultad de Ingeniería Mecánica de la Universidad Tecnológica de Pereira posee actualmente un sistema de visión artificial, el cual permite realizar comparaciones de formas, mas no de dimensiones de las piezas fabricadas en la ella; limitando el alcance del sistema en el momento de verificar exactitud de las dimensiones de dichas piezas. En el presente trabajo, se implementó una aplicación para el sistema de visión ya mencionado, que permitió realizar un dimensionamiento de las piezas fabricadas en la Celda, con el fin de realizar control de calidad sobre estas. A lo largo de este trabajo se explicarán cada uno de los pasos que se siguieron en la implementación de dicha aplicación, comenzando por mencionar algunos conceptos básicos sobre los sistemas de visión artificial, para pasar luego a la descripción del hardware y software utilizados y finalmente un análisis de los resultados obtenidos.. 12.

(13) OBJETIVOS OBJETIVO GENERAL Aplicar el software NI-IMAQ Vision en la celda de manufactura flexible de la Facultad de Ingeniería Mecánica de la Universidad Tecnológica de Pereira para realizar dimensionamiento a partir de la vista en planta de piezas con dimensiones máximas de 38 mm x 27 mm. OBJETIVOS ESPECÍFICOS Realizar un estudio de las técnicas de iluminación existentes determinando así, la más adecuada para el momento de la adquisición de las imágenes. Explorar el software NI-IMAQ y LabVIEW (ambos de la National Instruments), para identificar el método que se llevará a cabo para el tratamiento de la imagen. Elaborar un programa en LabVIEW que permita a través de las herramientas del IMAQ, tratar las imágenes de una forma automatizada para agilizar su posterior interpretación y análisis. Estimar los errores en las mediciones tomadas. Desarrollar un manual de uso y recomendaciones del programa elaborado, para que el trabajo aquí realizado sirva como soporte a otros proyectos relacionados con el tema.. 13.

(14) JUSTIFICACIÓN El uso de los sistemas de visión artificial en procesos de manufactura ha presentado un incremento, debido a que una adecuada implementación de estos sistemas, genera una gran oportunidad para la optimización de dichos procesos, además de facilitar el control de calidad de sus productos. Actualmente en la FMC (Flexible Manufacturing Cell) de la Universidad Tecnológica de Pereira, el análisis de imágenes que se realiza, con base en el reconocimiento de formas, proporciona información útil para diferenciar los tipos de piezas elaboradas; pero, en el momento de verificar la exactitud dimensional y el acabado de estas, dicho análisis no resulta útil. La realización de este proyecto brindará, mediante el análisis de tamaños en dos dimensiones de las piezas mecanizadas en la celda, un proceso más completo de interpretación de las imágenes adquiridas, lo que implica, que las conclusiones sacadas de dicho proceso sean más útiles, mejorando el desempeño de la celda y habilitándola para hacer comparaciones por metrología dimensional.. 14.

(15) 1. GENERALIDADES DE LOS SISTEMAS DE VISIÓN ARTIFICIAL La visión artificial o por computador es una técnica basada en la adquisición de imágenes, generalmente en dos dimensiones para su posterior procesamiento por ordenador, con el fin de extraer y medir determinadas propiedades de la imagen adquirida. Se trata por tanto de una tecnología que combina los ordenadores con las cámaras de video para adquirir, analizar e interpretar imágenes de una forma equivalente a la inspección visual humana.1 Actualmente se aplica en diversos procesos científicos y militares, extendiéndose su uso además en un amplio rango de sectores industriales (ver Figura 1.) para la automatización de tareas anteriormente reservadas para la inspección visual humana. Figura 1. Aplicaciones de la visión artificial.. Fuente: AITEX. 1. [AITEX] Asociación de Investigación de la Industria Textil. Análisis de la Tecnología de Visión Artificial Aplicada al Sector Textil [en línea]. Valencia (España).2002. [citado en 17 Abril de 2007]. <http://www.aitex.es/estudios/Vision_Artificial1.pdf>. 15.

(16) Capítulo 1 Generalidades de los Sistemas de Visión Artificial. Este incremento de utilización a nivel industrial es debido a que se trata de una tecnología especialmente útil en labores de inspección o supervisión siendo cuantitativamente más objetivos y consistentes que la inspección humana. Especialmente tienen un gran potencial de uso en la automatización de aquellas tareas en las que la inspección humana resulta ineficiente o costosa. Un sistema de visión artificial se compone básicamente de los elementos mostrados en la Figura 2. Figura 2. Elementos de un sistema de visión. Fuente: AITEX. Fuente de luz: Es un aspecto de vital importancia ya que debe de proporcionar unas condiciones de iluminación uniformes e independientes del entorno facilitando además si es posible la extracción de los rasgos de interés para una determinada aplicación. Sensor de imagen: Es el encargado de recoger las características del objeto bajo estudio. Tarjeta de adquisición de imágenes: Es la interfaz entre el sensor y el ordenador o módulo de proceso que permite al mismo tiempo, disponer de la información capturada por el sensor de imagen. Algoritmos de análisis de imagen. Es la parte “inteligente” del sistema. Su misión consiste en aplicar las necesarias transformaciones y extracciones de información de las imágenes capturadas con el fin de obtener los resultados para los que haya sido diseñado. Ordenador o módulo de proceso: Es el sistema que analiza las imágenes recibidas por el sensor, para extraer la información de interés en cada uno. 16.

(17) Capítulo 1 Generalidades de los Sistemas de Visión Artificial. de los casos; implementando y ejecutando los algoritmos diseñados para la obtención de los objetivos. Sistema de respuesta en tiempo real. Con la información extraída los sistemas de visión artificial pueden tomar decisiones que afecten al sistema productivo con el fin de mejorar la calidad global de la producción. Las técnicas de visión artificial como demuestra su aplicación en otros sectores industriales son particularmente apropiadas para la realización de trabajos visuales altamente repetitivos que sean fatigosos o difíciles de realizar para un operario especialmente cuando este trabajo es ineficiente o costoso en términos económicos y temporales.. 17.

(18) 2. INTRODUCCIÓN AL TRATAMIENTO DIGITAL DE IMÁGENES 2.1 LA IMAGEN DIGITAL Una imagen digital es un arreglo en 2D de valores que representan intensidad luminosa; es decir, una imagen digital es función de la intensidad luminosa:. Donde f es el brillo de punto (x,y), “x” y “y” representan las coordenadas espaciales del pixel. Por convención, el pixel con coordenadas (0,0) está ubicado en la esquina superior izquierda de la imagen (Figura 3.). Figura 3. Referencia Espacial del pixel (0,0). Fuente: National Instruments (NI). 2.2 PROPIEDADES DE LA IMAGEN DIGITAL La imagen digital tiene básicamente tres propiedades: Resolución: Es determinada por el número de filas o columnas de pixeles por los que está conformada la imagen. Definición: Indica la cantidad de tonos que se pueden observar en la imagen. Está directamente relacionada con el número de bits usado para codificar el valor de un pixel; para un número de bits n, la definición de la valores. imagen será de , indicando que el pixel puede tener Por ejemplo, para un número de bits de 8, cada pixel puede tener 256 valores diferentes.. 18.

(19) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. Número de planos: Corresponde al número de arreglos de pixeles que componen la imagen. Una imagen en escala de grises está compuesta por un solo plano, mientras que una imagen a color está compuesta por cuatro. 2.3 TIPOS DE IMÁGENES DIGITALES 2.3.1 Imagen Binaria Este tipo de imagen está formada por pixeles que solo pueden tener dos valores, 0 ó 255 para el caso de una definición de 8 bits. Las imágenes binarias son de gran utilidad para la aplicación de técnicas de detección de bordes, medición de áreas o distancias entre otras. 2.3.2 Imagen de Escala de Grises Está compuesta por un solo plano de pixeles donde cada pixel es codificado usando uno de los siguientes números: Un número entero sin signo de 8 bits representando valores de escala de grises entre 0 y 255. Un número entero con signo de 16 bits representando valores entre -32,768 y +32,767. Un número de punto flotante de 4 bytes representando valores desde . hasta 2.3.3 Imagen a Color Una imagen a color puede ser codificada de dos formas, RGB (Red, Green, Blue) ó HSL (Hue, Saturation, Luminance). En general, las imágenes a color están compuestas por cuatro planos; uno para el valor R ó H, otro para el valor G ó S, otro para el valor B ó L y un último plano llamado alfa que contiene información sobre la transparencia de cada pixel. La información del plano alfa es usada cuando se combinan múltiples imágenes para elaborar composiciones gráficas y efectos visuales en mapas2. 2. CDA INTERNATIONAL. Manifold System Release 7x User Manual [en línea]. 2003. [citado en 16 junio de 2007]. <http://www.manifold.net/doc/7x/manifold.htm#images.htm>. 19.

(20) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. 2.3.4 Imagen Compleja Una imagen compleja contiene la información de frecuencia de una imagen en escala de grises; dicha información se obtiene aplicando una FFT (Fast Fourier Transform) a la imagen. Luego de transformada la imagen, se le pueden aplicar operaciones en el domino de la frecuencia. 2.4 ANÁLISIS DE LA IMAGEN 2.4.1 Histograma El histograma es una herramienta fundamental de análisis que describe la distribución de la intensidad de los pixeles en la imagen y permite determinar cuántos pixeles existen para cada valor de la escala de grises. Con la ayuda del histograma se puede saber si la imagen es adecuada desde el punto de vista de exposición y contraste para un análisis exitoso3. Se define el histograma (Figura 4.) como la función definida en el rango , tal que el número de pixeles iguales al valor de escala de grises igual a es:. Donde:. es el valor de escala de grises. es el número de pixeles en la imagen con un valor de escala de grises igual a . Figura 4. Histograma. Fuente: NI. 3. NATIONAL INSTRUMENTS. IMAQ Vision Concepts Manual. Austin, Texas : NI, 2003. 315 p.. 20.

(21) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. La escala del eje vertical de histograma puede ser lineal o logarítmica (Figura 5.); en la segunda se visualizan mejor los valores de escala de grises usados por pocos pixeles: Figura 5. Tipos de escala vertical. Fuente: NI. 2.5 PROCESAMIENTO DE LA IMAGEN 2.5.1 LUT Las LUT (Lookup Table Transformations), son funciones básicas de procesamiento de imágenes que resaltan detalles en áreas que contienen información importante sacrificando otras áreas. Las LUT se usan para mejorar el contraste o el brillo modificando la intensidad dinámica de regiones con pobre contraste. Para el caso de una imagen de resolución de 8-bit, una LUT es una tabla de 256 elementos donde cada elemento de ésta representa un pixel y el valor de cada elemento indica el valor del pixel después de la transformación 2.5.2 Filtros. Los filtros espaciales cambian el valor del pixel respetando las variaciones de intensidad luminosa en sus alrededores. Estos alrededores están definidos por una matriz llamada kernel centrada en el pixel analizado.. 21.

(22) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. Los filtros espaciales pueden ser sensibles a la presencia o ausencia de variaciones en la intensidad luminosa. Estos filtros pueden ser usados con diferentes fines, tales como detección de aristas en una dirección específica, resaltar patrones, deducir ruido y suavizar detalles. El kernel es el encargado de especificar el grado de aporte de un pixel ubicado en los alrededores en el nuevo valor del pixel tratado. Lo anterior puede ser explicado de la siguiente forma: Si tomamos P(i,j) como el valor de la intensidad de un pixel con coordenadas (i,j), sus alrededores (de dimensión 3x3) pueden ser representados de la siguiente forma:. P(i-1,j-1). P(i,j-1). P(i+1,j-1). P(i-1,j). P(i,j). P(i+1,j). P(i-1,j+1). P(i,j+1). P(i+1,j+1). Y de forma similar el kernel se define como sigue:. K(i-1,j-1). K(i,j-1). K(i+1,j-1). K(i-1,j). K(i,j). K(i+1,j). K(i-1,j+1). K(i,j+1). K(i+1,j+1). A partir de esto, el nuevo valor del pixel P(i,j) sería:. Mientras mayor sea el valor absoluto de K(a,b), mayor será el aporte del píxel P(a,b) hacia el nuevo valor de P(i,j).. 22.

(23) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. Debido a que el nuevo valor del pixel P(i,j) se calcula a partir de una combinación lineal de los valores pertenecientes a los pixeles en los alrededores; se dice que el filtro es de tipo lineal. Entre los filtros lineales se encuentran: Gradiente: Resalta variaciones de intensidad luminosa a lo largo de una dirección específica, produciendo el efecto de delinear bordes y revelar texturas. En las figuras 6 y 7 se muestra el efecto de un filtro gradiente para la detección de bordes horizontales4: Figura 6. Imagen Original. Figura 7. Efecto de Filtro Gradiente. Fuente: NI. Laplaciano: Resalta variaciones de intensidad luminosa alrededor del pixel. Este filtro extrae el contorno del objeto y también los detalles. Para la misma imagen de la figura 6, el efecto del filtro Laplaciano se muestra en la figura 8:. 4. Ibid., p.94.. 23.

(24) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. Figura 8. Efecto del Filtro Laplaciano. Fuente: NI. Suavizado: Atenúa las variaciones de intensidad luminosa en los alrededores del pixel. Suaviza la forma de los objetos, difumina bordes y remueve detalles. El efecto de este filtro de muestra a continuación: Figura 9. Imagen Original. Figura 10. Efecto del Filtro de Suavizado. Fuente: NI. Gaussiano: Al igual que el filtro de suavizado, este filtro atenúa variaciones de intensidad luminosa; la diferencia radica en que el efecto de difuminación es menos fuerte que en el filtro de suavizado. En las figuras 11 y 12 se muestra el efecto del filtro Gaussiano:. 24.

(25) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. Figura 11. Imagen Original. Figura 12. Efecto del Filtro Gaussiano. Fuente: NI. 2.6 ANÁLISIS DE PARTÍCULAS Este análisis se usa para detectar regiones o grupos de pixeles llamados partículas, para luego realizar mediciones de parámetros sobre estas. Una partícula es una región continua de pixeles con valor diferente de cero. El análisis de partículas es una herramienta que usada de la forma correcta, puede ser de mucha ayuda en el momento de identificar formas, detectar defectos en las piezas fabricadas y realizar mediciones de estas. Para poder realizar el análisis, se requiere que la imagen sea de tipo binaria. Para la creación de imágenes binarias se usa un proceso llamado thresholding, el cual se explicará más adelante. En un típico proceso de análisis de partículas se realiza una búsqueda en toda la imagen, se detectan todas las partículas, y se crea un reporte para cada una. Para. 25.

(26) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. identificar una partícula se pueden usar múltiples parámetros como perímetro, área, y centro de masa.. 2.6.1 Thresholding Este proceso segmenta la imagen en dos regiones: la región de las partículas y la región del fondo. La forma en que realiza esta segmentación es cambiando a 1 el valor de todos los pixeles que pertenezcan a cierto intervalo en la escala de grises, y cambiando a 0 el valor del resto de los pixeles. El Thresholding es de gran ayuda para aislar las áreas en las que se va a centrar el análisis disminuyendo así, tiempo de procesamiento. El principal problema en la aplicación del thresholding, es la adecuada selección de intervalo (Threshold Interval). Este intervalo está definido por dos parámetros, el umbral superior y el umbral inferior. Todos los pixeles que tienen valores de escala de grises menores o iguales que el umbral superior y mayores o iguales que el umbral inferior, pertenecen a las partículas. En las figuras 13, 14 y 15 se muestra cómo actúa el thresholding: Tomando la siguiente imagen original: Figura 13. Imagen Original. Fuente: NI. 26.

(27) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. El histograma de la imagen es: Figura 14. Histograma. Fuente: NI. Extrayendo los pixeles que pertenecen al intervalo [166, 255], se tiene la siguiente imagen binaria: Figura 15. Efecto del Thresholding. Fuente: NI. Un problema muy común, luego de aplicar el thresholding, es que los bordes de las partículas no quedan muy bien definidos. Para solucionar este problema se pueden usar LUT’s, filtros o técnicas que se mencionarán más adelante. 2.6.2 Técnicas de Thresholding Automático Es recomendable, antes de aplicar alguna de las técnicas siguientes invertir la imagen original, especialmente si el fondo es claro y las partículas oscuras.5. 5. Ibid., p.145.. 27.

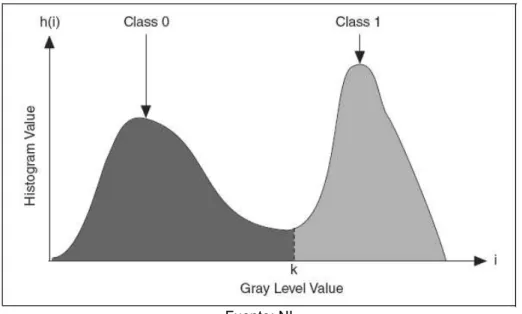

(28) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. Todos los métodos de thresholding automático usan el histograma para determinar el umbral. Las siguientes notaciones son usadas para describir los parámetros del histograma (ver Figura 16.): i – Representa el valor de escala de grises. k – Representa el valor de escala de grises escogido como umbral. – Representa el número de pixeles en la imagen para cada valor de i. N – Representa el número total de grises en la imagen (256 para una imagen de 8 bits). n – Número total de pixeles en la imagen. Figura 16. Thresholding Automático. Fuente: NI. La finalidad de estas técnicas es la de determinar el valor del umbral k de tal forma que los valores de grises que sean menores o iguales a k pertenecen a la clase 0 y los valores que sean mayores de k pertenecen a la clase 1. Ø Clustering. Esta técnica es la más usada de todas ya que es independiente de las condiciones luminosas de la escena. El valor del umbral es calculado como sigue:. Donde es la media de todos los valores de grises que están entre 0 y k y es la media de todos los valores de grises que están entre k+1 y 255.. 28.

(29) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. Ø Entropía. Este es el mejor método para detectar minúsculas partículas en la imagen. Está basado en la técnica de análisis clásica, en la cual la entropía se refiere a la cantidad de información asociada con el histograma y se explica a continuación: Se define:. Como la probabilidad de ocurrencia del nivel de grises i. La entropía del histograma de una imagen con niveles de grises en el rango [0, N-1] está dada por:. Si k es el valor de umbral, entonces las entropías para las dos fases del histograma son6:. El valor óptimo del umbral es aquel que maximiza la entropía de la imagen luego del thresholding. Esta entropía es:. Reemplazando y simplificando, el valor del umbral es el valor k para el cual la siguiente expresión es maximizada:. 6. Ibid., p.150.. 29.

(30) Capítulo 2 Introducción al Tratamiento Digital de Imágenes. Ø Varianza Interclase. Es una técnica estadística clásica de análisis similar al Clustering. Esta técnica es más apropiada para imágenes en las que las clases no son muy desproporcionadas. Para resultados satisfactorios, la clase más pequeña debe ser al menos el 5% de la más grande. Ø Métrico. En este método, el valor del umbral k debe ser tal que minimice la siguiente expresión:. Donde es la media de todos los valores de grises que están entre 0 y k y es la media de todos los valores de grises que están entre k+1 y 255. Ø Momentos. Esta técnica es adecuada para imágenes con pobre contraste y está basado en la hipótesis de que la imagen observada es una versión borrosa de la imagen binaria original, y que los momentos estadísticos (promedio y varianza) de la imagen original son iguales a los de la imagen procesada. El k-ésimo momento m de una imagen esta dado por:. Donde n es el número total de pixeles en la imagen.. 30.

(31) 3. TÉCNICAS DE ILUMINACIÓN La iluminación de la escena al momento de la adquisición, es de vital importancia para la obtención de imágenes con características especiales que permitan un mejor tratamiento y resultados más precisos. Una imagen con buen contraste, es decir que las regiones de interés se diferencien de las otras, es ideal para casi todas las aplicaciones de visión artificial. Existen varios tipos de iluminación que dependen explícitamente del tipo de aplicación a desarrollar y resaltan diferentes aspectos de las piezas a analizar. 3.1 ILUMINACIÓN POSTERIOR Esta técnica consiste en ubicar el objeto entre la fuente de iluminación y la cámara (Figura 17.). Este tipo de iluminación permite delinear el contorno de la pieza para su fácil dimensionamiento. Brinda un alto contraste entre la pieza y el fondo. Es fácil de implementar y de bajo costo. Figura 17. Iluminación Posterior. Fuente: INFAIMON. 3.2 ILUMINACIÓN FRONTAL Es la técnica más común de iluminación y consiste en posicionar la cámara y la fuente de luz en la misma dirección de tal forma que la cámara reciba la luz reflejada por el objeto (Figura 18.). Esta técnica es útil para inspeccionar superficies con pocos reflejos como el papel, la tela entre otros.. 31.

(32) Capítulo 3 Técnicas de Iluminación. Figura 18. Iluminación Frontal. Fuente: INFAIMON. 3.3 ILUMINACIÓN LATERAL Es utilizada para resaltar ciertos detalles laterales o para mostrar aspectos de la estructura superficial del objeto que solo son visibles orientando la luz de forma lateral a la posición de la cámara (Figura 19); con el inconveniente de que se pueden formar sombras indeseadas. Figura 19. Iluminación Lateral. Fuente: INFAIMON. 3.4 ILUMINACIÓN POR CAMPO OSCURO Esta técnica se utiliza para visualizar y leer caracteres o códigos de barras grabados en la superficie del material; también se usa para detectar defectos superficiales. Este tipo de iluminación se logra con el uso de anillos especiales que emiten haces de luz perpendiculares al eje de la cámara (Figura 20).. 32.

(33) Capítulo 3 Técnicas de Iluminación. Figura 20. Iluminación por Campo Oscuro. Fuente: INFAIMON. 3.5 ILUMINACIÓN COAXIAL Este tipo de iluminación se usa para observar objetos reflectantes, ya que contiene un espejo semitransparente que desvía los haces en el mismo eje de la cámara (Figura 21) generando una luz difusa homogénea que crea contraste entre las superficies reflectantes y las opacas. Este tipo de iluminación tiene el inconveniente de ser difícil de implementar y de alto coste. Figura 21. Iluminación Coaxial. Fuente: INFAIMON. 3.6 ILUMINACIÓN DIFUSA CONTINUA También llamada Iluminación de Día Nublado, esta técnica es utilizada para materiales extremadamente reflectantes y tiene la ventaja de no generar ningún tipo de sombra. La Iluminación Difusa Continua combina iluminación reflectante en una cúpula esférica e Iluminación Coaxial en la parte superior (Figura 22)7.. 7. INFAIMON. Fundamentos Teóricos- Iluminación [en línea]. Madrid (España). 2002. [Citado en 13 Junio de 2007]. <http://www.infaimon.com/catalogo/industria/iluminacion/teoricos/control.htm>. 33.

(34) Capítulo 3 Técnicas de Iluminación. Figura 22. Iluminación Difusa Continua. Fuente: INFAIMON. 34.

(35) 4. DESCRIPCIÓN DEL SOFTWARE 4.1 LABVIEW Creado por National Instruments, LabVIEW es una herramienta de programación gráfica que inicialmente fue concebida para realizar tareas de control a instrumentos de medición pero que actualmente es utilizada para fines tan diversos como automatización industrial, diseño, adquisición de datos, visión artificial, entre otros. Una de las ventajas del LabVIEW, es que puede ser usado tanto por programadores expertos, como por personas con pocos conocimientos en el tema ya que los programas, por estar “dibujados” y no escritos en líneas de código, se pueden comprender fácilmente. Los programas realizados en LabVIEW se llaman instrumentos virtuales “VIs”, ya que tienen la apariencia de instrumentos reales, sin embargo, poseen analogías con funciones provenientes de lenguaje de programación convencionales.8 Los VIs están conformados por dos interfaces: el panel frontal y el diagrama de bloques. El panel frontal es la interfaz con el usuario, ya que se pueden ingresar datos y visualizar resultados. En el diagrama de bloques se encuentra todo el código fuente del VI. 4.2 NI IMAQ NI IMAQ es un paquete de funciones que controla el hardware de adquisición de imágenes y además contiene métodos para ejecutar tareas, que van desde la inicialización del hardware, adquisiciones simples y secuenciales, hasta adquisiciones avanzadas a alta velocidad.9. 8. HOLGUÍN, Germán; PERÉZ, Sandra y OROZCO, Álvaro. Curso básico de LabVIEW 6i. Pereira: Universidad Tecnológica de Pereira, 2002. 265 p. ISBN 958-8065-33-X. 9 NATIONAL INSTRUMENTS. NI-IMAQ User Manual. Austin, Texas: NI, 2003. 112 p.. 35.

(36) Capítulo 4 Descripción del Software. 4.3 IMAQ VISION Es una librería de VIs que se puede usar para crear una gran variedad de aplicaciones de visión artificial, ya que contiene funciones específicas para cada etapa en la implementación de un sistema de visión. Dichas funciones son: Utilidades de Visión: Permiten crear imágenes, cambiarles el tamaño, calibrarlas, manipular pixeles, mostrarlas en pantalla, guardarlas en archivos y en diferentes formatos. Procesamiento de Imágenes: Permiten aplicar a las imágenes técnicas de análisis y procesamiento como el histograma, los filtros, el thresholding y el análisis de partículas. Visión por Máquina: Estas funciones realizan tareas como conteo de objetos, detección de aristas, comparación de patrones, medición de distancias y ángulos. 4.4 VISION ASSISTANT Como su nombre lo dice es un asistente que permite realizar la estrategia de la aplicación sin ningún tipo de programación; ya que genera automáticamente el código en LabVIEW. Sin embargo luego de ejecutar el asistente, se le deben agregar al código algunos elementos adicionales para mejorar el desempeño de la aplicación. El asistente tiene acceso a todas las librerías, ya sean del LabVIEW, del NI IMAQ o de IMAQ Vision; por lo que simplifica la fase inicial de la elaboración de la aplicación. Además, el asistente facilita enormemente el proceso de calibración de las imágenes. 4.5 MEASUREMENT & AUTOMATION EXPLORER (MAX) Es un explorador que permite configurar todo el hardware y software de National Instruments instalado en el equipo. Mediante el MAX se pueden crear o editar nuevas interfaces, tareas y canales para cada dispositivo. El MAX ofrece una buena herramienta para modificar parámetros de operación del hardware con el fin de mejorar su desempeño en una aplicación específica.. 36.

(37) 5. DESCRIPCIÓN DEL HARDWARE El hardware con el que se dispone inicialmente en el laboratorio se describe a continuación. 5.1 TARJETA DE ADQUISICIÓN IMÁGENES La tarjeta de adquisición usada es la IMAQ PCI 1408 de National Instruments (Figura 23), cuyas características se muestran en la Tabla 1. Figura 23. Tarjeta de Adquisición de imágenes IMAQ PCI 1408. 37.

(38) Capítulo 5 Descripción del Hardware. Tabla 1. Características de la IMAQ PCI 1408 Resolución Número de entradas de video Impedancia a la entrada Niveles de gris Voltaje Dimensiones Peso Temperatura de operación. 1 Mega Píxel 4 75 Ω 256 (8 bits) +12V (100mA) -12V (50mA) 10.668 x 17.463 cm 0.127 kg 0-55°C. 5.2 CÁMARA La cámara empleada para la captura de las imágenes es una CCD MINTRON MS1131C (Figura 24). Los principales atributos de esta cámara se listan en la Tabla 2. Figura 24. Cámara CCD MINTRON MS1131C. Fuente: mintron.com. 38.

(39) Capítulo 5 Descripción del Hardware. Tabla 2. Características de la cámara MS1131C Chip Sensor Área del Sensor. SHARP 4.8mm (H)X3.6mm (V) 542(H) X 582(V) (CCIR) Elemento de la imagen 542(H) X 492(V) (EIA) Distancia Focal 16mm Resolución 420 líneas Voltaje DC 12V Iluminación mínima 0.05Lux de F1.2 Dimensión 50.5mm(W)X50.5mm(H)X115mm(L) Peso 410 g 5.3 CAJA DE LUZ La caja de luz (Figura 25) inicialmente cuenta con una lámpara fluorescente de 8W y un acrílico opaco para evitar el deslumbramiento. Figura 25. Caja de Luz. 39.

(40) 6. IMPLEMENTACIÓN DE LA APLICACIÓN 6.1 SELECCIÓN DE LA TÉCNICA DE ILUMINACIÓN Para la adecuada selección de la técnica de iluminación a utilizar, se elaboró el siguiente cuadro comparativo (Tabla 3). Tabla 3. Comparación de las Técnicas de Iluminación Iluminación. Ventajas. Iluminación Posterior. Fácil de implementar, bajo costo, crea silueta de la pieza, imágenes de muy alto contraste.. Iluminación Frontal. Fácil de implementar, revela algunos detalles superficiales.. Iluminación Lateral. Fácil de implementar, revela algunos detalles superficiales.. Iluminación por Campo Oscuro Iluminación Coaxial Iluminación Difusa Continua. Ilumina defectos superficiales, provee imágenes de alto contraste en algunas aplicaciones. Elimina sobras, iluminación uniforme en todo el campo de visión. Elimina sombras, elimina el deslumbramiento.. Desventajas Se debe tener espacio detrás del objeto. Puede crear sombras indeseadas, la iluminación no es uniforme. Puede crear sombras indeseadas, la iluminación no es uniforme. No ilumina de forma plana, difumina las superficies. Difícil de implementar, reflexión intensa en superficies brillantes. Debe rodear el objeto, el iluminador es grande, puede ser costosa.. Como la tarea principal de la aplicación de visión artificial en la celda de manufactura es la de realizar mediciones de dimensiones, se requiere de una imagen de alto contraste y con el contorno bien definido. Teniendo en cuenta lo mencionado anteriormente, y como se dispone de una caja de luz apropiada para iluminación posterior; se selecciona esta como la técnica de iluminación que mejor se ajusta a los requerimientos de la aplicación tanto técnicos como económicos.. 40.

(41) Capítulo 6 Implementación de la Aplicación. 6.2 ADECUACIÓN DE LA ESCENA En la celda de manufactura se cuenta con una caja de luz, la cual tiene como fuente de luz una lámpara fluorescente de 8 W. También se dispone de un soporte para ubicar y nivelar la cámara, con el fin de que el eje de ésta, quede perpendicular a la superficie de la caja de luz. Debido a que nivelar la cámara es un trabajo que requiere de mucha precisión y mover la cámara de su posición no era tan sencillo; se optó por adecuarle a la caja de luz cuatro patas niveladoras mostradas en la figura 26, facilitando el proceso de nivelación con respecto a la cámara. En dicho proceso se emplearon niveles de precisión suministrados por el taller de la Facultad de Ingeniería Mecánica. Figura 26. Nivelación de la Caja de Luz. Para aumentar el contraste en las imágenes adquiridas, se le incorporó a la caja otra lámpara de iguales características. Para determinar la distancia óptima de la cámara respecto a la superficie de la mesa (distancia de trabajo), se empleó la siguiente ecuación:. Teniendo en cuenta que la longitud máxima a medir en la dirección vertical es de 27 mm y dejándose un espacio de 1 mm entre la pieza y el borde de la imagen; se tiene un campo de visión en esta dirección de aproximadamente 29mm.. 41.

(42) Capítulo 6 Implementación de la Aplicación. Como la distancia focal del lente y el tamaño del sensor de la cámara son parámetros fijos, se calculó la distancia de trabajo más adecuada para el sistema por medio de la ecuación anterior, obteniendo un resultado de:. Con esta distancia y usando la dimensión horizontal del sensor (ver tabla 2), se obtiene un campo de visión horizontal de:. 6.3 CALIBRACIÓN DEL SISTEMA La calibración espacial del sistema de visión, es de vital importancia ya que del éxito de este proceso, depende la confiabilidad de todo el sistema. El principio en el que se basa la calibración, es el de asignarle a algunos pixeles conocidos sus coordenadas en unidades reales y con la información obtenida calcular las coordenadas reales de los demás pixeles. La forma en la que se calculan las demás coordenadas puede ser perspectiva o no lineal. Cuando el eje de la cámara no está perpendicular al objeto, el tipo de calibración a usar es por perspectiva; pero si a eso se le agrega la distorsión causada por aberraciones del lente de la cámara, la calibración más adecuada es la no lineal.10 Antes de comenzar con la calibración se comprobó que la cámara se encontraba lo mas perpendicular posible a la mesa; esto con el fin de eliminar al máximo los errores de perspectiva. Para efectuar la calibración se elaboró una malla conformada por puntos igualmente espaciados a una distancia conocida. La determinación del diámetro de los puntos y la distancia entre estos se realizó teniendo en cuenta que en la imagen adquirida los puntos debían tener un radio de 6 a 10 pixeles y una 10. Ibid., p. 58-59.. 42.

(43) Capítulo 6 Implementación de la Aplicación. distancia entre centros de 18 a 32 pixeles11. Luego de varias pruebas se llegó la malla definitiva, la cual está formada por puntos con 0.7 mm de diámetro y a una distancia de 1.3 mm. La malla se muestra en la figura 27 (Aumentada 10 veces). Figura 27. Malla de Calibración. Para el caso de la calibración por perspectiva no es necesario que los puntos ocupen toda el área de la imagen ya que este tipo de calibración realiza un mapeo de pixeles a unidades reales para la región cubierta por los puntos y luego este mapeo se puede usar para convertir las coordenadas cualquier otro pixel de la imagen. En la calibración no lineal el mapeo es realizado en una región rectangular alrededor de cada punto de la malla. La información necesaria para el mapeo en cada punto es estimada a partir de los puntos que lo rodean. Debido a esto solo el área de la imagen que esté cubierta por la malla es calibrada con precisión. Al momento de adquirir la imagen de la malla, se realizaron algunos cambios en la configuración de la tarjeta de adquisición para que los puntos en la imagen quedaran bien definidos, facilitando así el proceso de calibración. Debido a que el área cubierta por los puntos (negro) era mucho menor que el área clara, la diferencia de intensidad luminosa entre los puntos y el fondo no era la adecuada para realizar el thresholding. Para solucionar este inconveniente se modificaron por medio del MAX los niveles de referencia del blanco y del negro de la tarjeta de adquisición (Figuras 28 y 29).. 11. NATIONAL INSTRUMENTS. IMAQ Vision for LabVIEW User Manual. Austin, Texas : NI, 2003. 131 p.. 43.

(44) Capítulo 6 Implementación de la Aplicación. Figura 28. Niveles de referencia iniciales. Figura 29. Niveles de referencia finales. 44.

(45) Capítulo 6 Implementación de la Aplicación. Al disminuir el nivel de referencia del blanco se eliminan los tonos grises cercanos al blanco y al aumentar el nivel de referencia del negro se eliminan los tonos grises cercanos al negro. Esto aumenta la diferencia de intensidad luminosa en toda la imagen dejándola más apta para el thresholding. Además, la tarjeta IMAQ PCI 1408 estaba configurada para realizar adquisiciones en modo normal; es decir, las zonas claras en la escena se veían de igual manera en la imagen y de la misma forma las zonas oscuras en la escena se veían oscuras en la imagen. Este hecho generaba un problema en el proceso de calibración, ya que cuando se realiza el thresholding para detectar los puntos de la malla, en lugar de detectar los puntos que eran oscuros, se detectaban las zonas claras. Para corregir este problema se cambió en MAX el modo de adquisición de la tarjeta de normal a inverso (Figura 30). En este modo las zonas claras de la escena se ven oscuras en la imagen y viceversa. Figura 30. Cambio del modo de adquisición. 45.

(46) Capítulo 6 Implementación de la Aplicación. Finalmente se adquiere la imagen definitiva de la malla de calibración que se muestra en la Figura 31. Figura 31. Malla de calibración. Para realizar el proceso de calibración se utilizó el Vision Assistant comenzando por la adquisición de la imagen a calibrar, luego se selecciona el tipo de distorsión, posteriormente se realiza el thresholding a la malla de calibración para detectar los puntos y darles su respectiva distancia en unidades reales y finalmente guardar la información de la calibración. Para una descripción más detallada de cada uno de los pasos ver el Anexo A. Al finalizar el proceso de calibración se guarda otra imagen de la malla con formato png, la cual almacena toda la información de la calibración con el fin de hacer más fácil la propagación de esta en toda la aplicación. Los niveles de referencia del blanco y del negro en la IMAQ PCI 1408 se cambian a sus valores iniciales luego de la calibración.. 46.

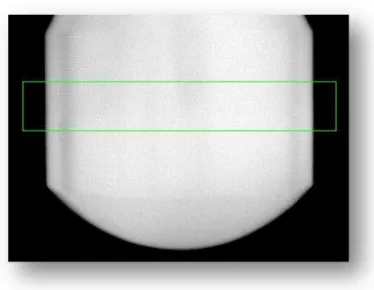

(47) Capítulo 6 Implementación de la Aplicación. 6.4 MODIFICACIONES FINALES Como todos haces de luz de la caja no son perpendiculares al eje de la cámara, los bordes de la pieza no se veían bien definidos dificultando la detección de estos. Debido a esto se optó por disminuir el paso de luz alrededor de la pieza evitando que esta quedara iluminada por los lados. (Ver Figuras 32 y 33). Figura 32. Modificación. 47.

(48) Capítulo 6 Implementación de la Aplicación. Figura 33. Implementación de la modificación. De esta forma se mejora la definición de las aristas y por ende se facilita su detección. Se debe aclarar que esta modificación no afecta el contraste de la imagen ya que solo se disminuye la cantidad de luz sin afectar su intensidad.. 48.

(49) 7. DESCRIPCIÓN DEL PROGRAMA El código del programa escrito en lenguaje G en LabVIEW, genera una alta automatización de la aplicación de visión y permite al usuario establecer los parámetros de funcionamiento de la misma. El objetivo del programa es el de realizar un control dimensional a las piezas producidas en el torno de control numérico de la celda de manufactura flexible. Este control se hace comparando las dimensiones de la pieza producida con las dimensiones de una pieza patrón. Si la diferencia entre las dimensiones excede las tolerancias establecidas por el usuario la pieza es rechazada, de lo contrario es aceptada. El programa se divide en dos partes: una que recibe la información sobre las mediciones que se va a realizar, y la otra que ejecuta las mediciones. En la primera parte del programa, se deben establecer las dimensiones de la pieza patrón, lo cual incluye indicar el tipo de medida, el valor nominal y la región donde realizará cada medición. El programa está diseñado para aceptar tres tipos de medidas: Lineal: Son todas las medidas de los diámetros en piezas cilíndricas. La región donde se realiza la medición está definida por un rectángulo ubicado como se muestra en la Figura 34. Figura 34. Medición lineal. 49.

(50) Capítulo 7 Descripción del Programa. Radial: Son las medidas de radios de curvatura. La región de medición está definida por un anillo como se muestra en la Figura 35. Figura 35. Medición Radial. Angular: Son las mediciones de cualquier ángulo con respecto a la vertical. La región de medida está definida por un rectángulo rotado como se muestra en la Figura 36. Figura 36. Medición Angular. 50.

(51) Capítulo 7 Descripción del Programa. En ninguno de los tres tipos de mediciones las regiones deben contener aristas diferentes a las de interés, por ejemplo, regiones de medición como las mostradas en la Figura 37 provocarán grandes errores en las medidas.. Figura 37. Mediciones Incorrectas. Luego de ingresar cada una de las medidas con las que se van a comparar las demás piezas; lo que incluye tipo de medición, región de medición y valor nominal; se guarda esta información automáticamente en un archivo para su posterior uso. Este archivo además almacena el nombre de la pieza al que pertenece el grupo de mediciones. La segunda parte del programa recibe como datos de entrada las tolerancias tanto para las mediciones de longitudes como para las de ángulos y arroja como resultados los errores en cada una de las mediciones. Esta parte del programa posee un componente de reconocimiento de imágenes, el cual luego de adquirir la imagen, la compara con unos patrones preestablecidos para determinar que pieza es y los lugares donde debe efectuar las mediciones. Para poder comprender el funcionamiento del programa en forma general, se muestra a continuación su diagrama de flujo (Diagramas 1 y 2).. 51.

(52) Capítulo 7 Descripción del Programa. Diagrama 1. Primera parte del programa. Adquisición. Datos de Medición. No. Conforme?. No. Si Si. Datos Completos?. Guardar Archivo. Aprender Patrones. Fin. Diagrama 2. Segunda parte del programa. Espera No Pieza en Posición? Si Datos de usuario. Adquirir. Patrones. Comparar. A. 52.

(53) Capítulo 7 Descripción del Programa. A. Patrón 1?. No. Si Datos Patrón 1. Realizar Mediciones. No. B. Patrón 2? Si. B. Realizar Mediciones. Datos Patrón 2. Patrón 3? Si Datos Patrón 3. B. Realizar Mediciones. Guardar Datos. FIN. 53. B.

(54) 8. INCERTIDUMBRE EN LAS MEDICIONES Existen muchas formas de calcular el error en las mediciones hechas por el sistema de visión y también existen muchos factores que pueden provocar dichos errores. Dependiendo de la naturaleza de dichos factores, las incertidumbres se clasifican en dos tipos. Las incertidumbres que son inherentes al instrumento de medida se denominan tipo B y las que están relacionadas con otros aspectos, pero se ven reflejadas en los datos de medición se denominan tipo A. 8.1 CALCULO DE LA INCERTIDUMBRE TIPO B En un sistema de visión artificial, los elementos que más influyen en la exactitud del mismo son la cámara y el lente, ya que del tamaño del sensor de la cámara y del aumento generado por el lente depende en gran parte el error en cada una de las mediciones realizadas. Para el cálculo de la incertidumbre en las medidas ocasionadas por la cámara y el lente se tomó como base el procedimiento recomendado por Edmund Optics Inc12. En primera instancia se define el aumento primario (Primary Magnification) que corresponde al aumento de los lentes así:. Luego se calcula la resolución de la cámara en pares de líneas por milímetro, es decir, los pares de líneas que puede diferenciar la cámara en un milímetro.. En la ecuación anterior se usa una relación de aspecto del sensor de 4:3.. 12. Edmund Optics. Technical Support [en línea]. New Jersey (USA). 2007. [Citado en 12 de Julio de 2007]. <http://www.edmundoptics.com/techSupport/DisplayArticle.cfm?articleid=301>. 54.

(55) Capítulo 8 Incertidumbre en las Mediciones. La resolución de la cámara también se puede expresar como la distancia mínima que deben tener dos líneas adyacentes para ser diferenciadas con éxito. Esta resolución se calcula como sigue:. La resolución del sistema (cámara+lente) se obtiene mediante la siguiente ecuación:. La incertidumbre tipo B por resolución se calcula mediante la siguiente expresión:. Donde P es una constante que toma el valor de “2” para instrumentos digitales, quedando de la siguiente forma:. Como el campo de visión es tan grande, se disminuye la capacidad del sistema de diferenciar dos líneas cercanas. Para imágenes de alto contraste, al momento de estimar la exactitud en las mediciones se debe asumir un error inherente al proceso de medición. Este error se encuentra entre 1 y 3 pixeles.. 55.

(56) Capítulo 8 Incertidumbre en las Mediciones. La incertidumbre tipo B por exactitud está dada por la siguiente fórmula:. Para las mediciones angulares, se calculó la incertidumbre basada en la calculada anteriormente de la siguiente manera: Figura 38. Incertidumbre angular. En la Figura 38 se observa la variación de una medida angular en función de la variación en la posición de uno de los lados que forman el ángulo. La incertidumbre angular no solo depende de , sino que también depende del valor del ángulo y de la distancia . La incertidumbre angular tipo B se calcula como sigue:. 56.

(57) Capítulo 8 Incertidumbre en las Mediciones. 8.2 CÁLCULO DE LA INCERTIDUMBRE TIPO A Para el cálculo de la incertidumbre tipo A se analizaron los datos obtenidos luego de realizar mediciones consecutivas a una misma pieza. También tomaron datos a diferentes tipos de piezas y finalmente se seleccionaron para el análisis los datos más críticos, es decir, los que presentaban la mayor variación. En la Tabla 4 se muestran estos datos con su respectivo error tomando como valor real 19,09mm. Tabla 4. Mediciones realizadas Valor Medido Error 19,17 0,08 19,38 0,29 19,16 0,07 19,17 0,08 19,31 0,22 19,17 0,08 19,16 0,07 19,31 0,22 19,31 0,22 19,16 0,07 En primera instancia, se calcula la media de los datos usando la siguiente fórmula:. Luego se obtiene la varianza por medio de la siguiente expresión:. La desviación estándar del grupo de datos es:. 57.

(58) Capítulo 8 Incertidumbre en las Mediciones. Finalmente, la incertidumbre tipo A del proceso de medición está dada por la siguiente ecuación:. El valor de t se estima basándose en el hecho de que la distribución de datos usada es la de t-student (Anexo B); la cual, para una confiabilidad del 95% y un número de datos de 10, arroja un valor de t=2,262 La incertidumbre declarada del proceso de medición se define como sigue:. Donde: se denomina coeficiente de cobertura, el cual para una confiabilidad del 95% es de 1,9613 (ver Anexo C). se calcula como sigue:. La incertidumbre declarada queda así:. 13. RONCONI, Adrián E. Cátedra de Instrumentos y Mediciones [en línea]. Argentina: Universidad Nacional de Quilmes, Ingeniería en Automatización y Control Industrial, 2006. [Citado en 5 de Noviembre de 2007]. <http://iaci.unq.edu.ar/Materias/ins_med/archivos/Instymed_t1.pdf>.. 58.

(59) 9. RESULTADOS Se obtuvo como resultado de este trabajo, el desarrollo de una aplicación que permita medir algunas dimensiones de las piezas realizadas en la FMC de la Facultad de Ingeniería Mecánica por medio del sistema de visión artificial de esta. Las mediciones realizadas con el sistema de visión artificial tendrán una incertidumbre declarada del proceso de con una confiabilidad del 95%. Las mediciones angulares tendrán una incertidumbre mínima de 0.217 grados midiendo un ángulo de 1 grado en una distancia de 30 mm; y una máxima de 1.81 grados midiendo un ángulo de 45 grados en una distancia de 5 mm. La aplicación también estará en condición de decidir si la pieza cumple o no con los requerimientos necesarios. Estos requerimientos son establecidos por el usuario mediante una tolerancia máxima permisible entre la medida arrojada por el programa y el valor de referencia. Esta tolerancia debe estar dentro de los límites establecidos por la incertidumbre; es decir debe estar dentro del intervalo . Tambien se dispone de una salida que indica el estado de la pieza; es decir, cuando la salida arroja el valor “True”, quiere decir que la pieza cumple con las tolerancias establecidas; si la salida tiene el valor de “False” la pieza se clasifica como rechazada. Esta salida pude ser usada como indicador luminoso o servir de entrada para otras aplicaciones relacionadas. 9.1 DATOS OBTENIDOS Se realizaron mediciones de dos piezas diferentes las cuales incluyen diámetros, ángulos y radios. Para la pieza Nº 1 (Figura 39) se efectuaron las siguientes medidas que se muestran en la Tabla 5 igual que el VCV (Valor Convencionalmente Verdadero) con su rango de incertidumbre.. 59.

(60) Capítulo 9 Resultados. Figura 39. Pieza Nº1. Tabla 5. Medidas realizadas a la Pieza Nº1 Medición. Valores (mm) 19.174166 19.165163 19.162226 19.167276 19.159588 19.159588 19.157442 19.196444 19.207264 19.163040 19.184093 19.174559 19.182878 19.180252 19.188154 19.183964 19.182474 19.186205 19.207264 19.185452. 60. VCV (mm).

(61) Capítulo 9 Resultados. 11.246223 11.211745 11.276271 11.257164 11.274823 11.205421 11.224877 11.200355 11.239444 11.273838 12.200832 12.225261 12.357512 12.294744 12.378932 12.273051 12.337732 12.649014 12.570091 12.311145. Las mediciones de radios presentan un gran error con respecto a la medida real, esto se debe principalmente a que la calibración realizada a la imagen no corrige el alargamiento presentado en ésta, ocasionando que los arcos de la pieza se vean en la imagen con un menor o mayor radio dependiendo de su orientación. Las mediciones realizadas para la pieza Nº2 (Figura 40) se muestran en la Tabla 6.. 61.

(62) Capítulo 9 Resultados. Figura 40. Pieza Nº2. Tabla 6. Mediciones realizadas a la pieza Nº2 Medición. Valor (mm) 16.494074 16.478548 16.542700 16.621799 16.485552 16.480511 16.643625 16.544333 16.528894 16.624495. 62. VCV (mm).

(63) Capítulo 9 Resultados. 21.086615 21.133123 21.160656 21.116722 21.106489 21.130497 21.121391 21.130400 21.099991 21.107376 21.987123 21.932720 21.899061 21.914299 21.947367 21.950466 21.973495 21.959665 21.924944 21.988077 28.717108 28.705828 28.716892 28.710352 28.900406 28.726143 28.981955 28.869150 28.754910 28.827511 La alta incertidumbre en las mediciones hechas con el sistema de visión, se debe a diferentes factores como: La técnica de iluminación, a pesar de ser la recomendada para el tipo de aplicación a realizar, genera una gran variación en las medidas debido al tipo de lámparas usadas, la frecuencia a la que estas trabajan y a la forma en que los haces luminosos llegan al sensor de la cámara (ver numeral 6.4). La calibración (ver numeral 6.3) realizada puede no eliminar del todo los errores por perspectiva y distorsión causados por los lentes, más aun cuando la distorsión del lente usado es tan pronunciada. Para corregir este problema se hace necesaria la adquisición de lentes con un proceso de fabricación más refinado que permitan la disminución de la distorsión.. 63.

(64) Capítulo 9 Resultados. Aunque la cámara tiene una resolución aceptable , se tiene una baja resolución del sistema debido a que la relación entre el tamaño del sensor , es menor que la unidad. Para solucionar esto se y el campo de visión puede optar por utilizar otra cámara con un sensor más grande o disminuir el campo de visión, lo que eliminaría la posibilidad de tomar todas las medidas aquí propuestas.. 64.

(65) 10. CONCLUSIONES Y RECOMENDACIONES La posibilidad de realizar mediciones a las piezas elaboradas en la celda, le adiciona un componente de control de calidad a ésta, aumentando su versatilidad y desempeño ya que el sistema de visión anterior solo estaba habilitado para reconocer formas. El tipo de iluminación utilizada en el sistema de visión es un factor determinante en el buen funcionamiento de este, ya que de una buena selección de la técnica de iluminación depende la confiabilidad de los resultados obtenidos del sistema. El uso adecuado del software le agrega un alto grado de automatización a la aplicación, facilita la calibración y es indispensable para el tratamiento adecuado de las imágenes. La selección del hardware adecuado para cada tipo de aplicación es uno de los aspectos más importantes cuando se diseña un sistema de visión artificial; la precisión y exactitud requerida está directamente ligada a características del hardware como son la resolución, tolerancia, nivel de ruido, estabilidad entre otras. De una buena calibración espacial de las imágenes adquiridas depende la confiabilidad de las mediciones tomadas en ellas. Para la aplicación desarrollada, el mayor aporte en la incertidumbre global lo hizo la incertidumbre tipo B por exactitud, indicando que el campo de visión no es el adecuado para la cámara utilizada. Se recomienda realizar un análisis más profundo de la iluminación en lo referente al tipo de fuente luminosa, la cual puede ser por medio de leds no convencionales; y a la forma en la que los rayos llegan al sensor. Para eliminar definitivamente los errores de perspectiva, se sugiere la adquisición de lentes telecéntricos, los cuales solo dejan pasar los haces de luz que son paralelos al eje de la cámara. Con el fin de aumentar la exactitud el sistema sin disminuir el campo de visión, es necesaria una cámara con un sensor más grande que el actual (se recomienda un sensor de ½” o mayor).. 65.

(66) BIBLIOGRAFÍA [1] [AITEX] Asociación de Investigación de la Industria Textil. Análisis de la Tecnología de Visión Artificial Aplicada al Sector Textil [en línea]. Valencia (España).2002. [citado en 17 Abril de 2007]. [2] CDA INTERNATIONAL. Manifold System Release 7x User Manual [en línea]. 2003. [citado en 16 junio de 2007]. <http://www.manifold.net/doc/7x/manifold.htm#images.htm> [3] NATIONAL INSTRUMENTS. IMAQ Vision Concepts Manual. Austin, Texas: NI, 2003. 315 p. [4] INFAIMON. Fundamentos Teóricos- Iluminación [en línea]. Madrid (España). 2002. [Citado en 13 Junio de 2007]. <http://www.infaimon.com/catalogo/industria/iluminacion/teoricos/control.htm> [5] HOLGUÍN, Germán; PÉREZ, Sandra y OROZCO, Álvaro. Curso básico de LabVIEW 6i. Pereira: Universidad Tecnológica de Pereira, 2002. 265 p. ISBN 958-8065-33-X. [6] NATIONAL INSTRUMENTS. NI-IMAQ User Manual. Austin, Texas: NI, 2003. 112 p. [7] NATIONAL INSTRUMENTS. IMAQ Vision for LabVIEW User Manual. Austin, Texas : NI, 2003. 131 p. [8] Edmund Optics. Technical Support [en línea]. New Jersey (USA). 2007. [Citado en 12 de Julio de 2007]. <http://www.edmundoptics.com/techSupport/DisplayArticle.cfm?articleid=301> [9] RONCONI, Adrián E. Cátedra de Instrumentos y Mediciones [en línea]. Argentina: Universidad Nacional de Quilmes, Ingeniería en Automatización y Control Industrial, 2006. [Citado en 5 de Noviembre de 2007]. <http://iaci.unq.edu.ar/Materias/ins_med/archivos/Instymed_t1.pdf>.. 66.

(67) ANEXO A. MANUAL DE CALIBRACIÓN Y USO 1. CALIBRACIÓN La calibración es uno de los pasos más importantes en la implementación del sistema de visión, ya que de el éxito de este paso depende la confiabilidad del todo el sistema. 1.1 NIVELACIÓN El proceso de calibración comienza con la nivelación de la cámara con respecto a la superficie de la mesa. Esta nivelación consiste en mover los elementos (cámara y/o mesa) para que el eje de la cámara quede lo más perpendicular posible a la mesa, con el fin de eliminar al máximo los errores de perspectiva. Para realizar este procedimiento se puede hacer uso de niveles de precisión y escuadras, disponibles en el taller de la Facultad de Ingeniería Mecánica. Durante el proceso de nivelación se debe tener especial cuidado en dejar la cámara centrada, es decir, que al momento de adquirir la imagen la zona de medición quede en el centro de esta. También se debe ajustar la distancia de la cámara a la superficie de la mesa. Dicha distancia, depende del campo de visión deseado, de la distancia focal del lente de la cámara y del tamaño del sensor de esta. Se calcula mediante la siguiente ecuación:. Para la cámara disponible en la celda se tiene una distancia focal de 16 mm y un sensor CCD de 4.8 mm (H) x 3.6 mm (V). 1.2 MALLA DE CALIBRACIÓN La malla de calibración es el elemento por medio del cual se convierten las coordenadas de todos los pixeles de la imagen a unidades reales. Esta malla está formada por puntos de determinado diámetro e igualmente espaciados como se muestra en la Figura 1.. 67.

Figure

Outline

Documento similar

Cedulario se inicia a mediados del siglo XVIL, por sus propias cédulas puede advertirse que no estaba totalmente conquistada la Nueva Gali- cia, ya que a fines del siglo xvn y en

No había pasado un día desde mi solemne entrada cuando, para que el recuerdo me sirviera de advertencia, alguien se encargó de decirme que sobre aquellas losas habían rodado

Habiendo organizado un movimiento revolucionario en Valencia a principios de 1929 y persistido en las reuniones conspirativo-constitucionalistas desde entonces —cierto que a aquellas

In medicinal products containing more than one manufactured item (e.g., contraceptive having different strengths and fixed dose combination as part of the same medicinal

Products Management Services (PMS) - Implementation of International Organization for Standardization (ISO) standards for the identification of medicinal products (IDMP) in

Products Management Services (PMS) - Implementation of International Organization for Standardization (ISO) standards for the identification of medicinal products (IDMP) in

This section provides guidance with examples on encoding medicinal product packaging information, together with the relationship between Pack Size, Package Item (container)

Package Item (Container) Type : Vial (100000073563) Quantity Operator: equal to (100000000049) Package Item (Container) Quantity : 1 Material : Glass type I (200000003204)